开源大模型实战指南 从部署到微调

《开源大模型食用指南》提供全流程教程,支持主流模型部署、微调与应用,适合学生和开发者快速上手。

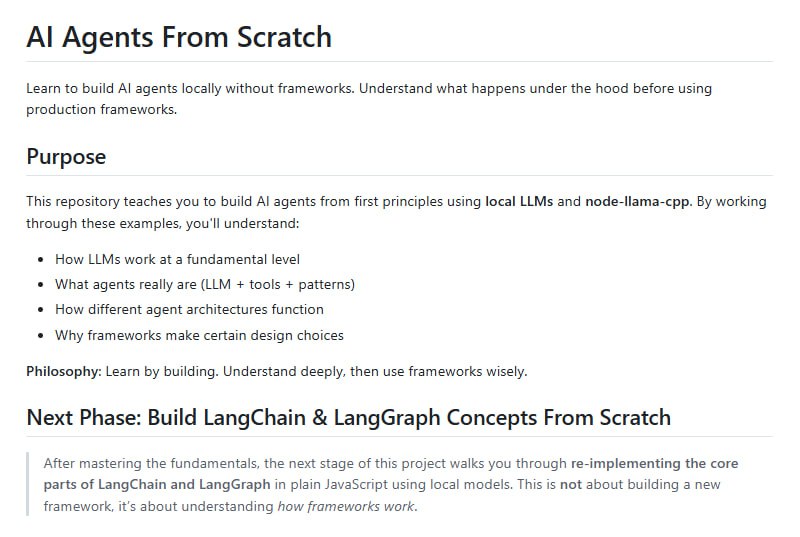

随着人工智能技术的快速发展,开源大模型已成为学术界和工业界关注的焦点。然而对于初学者而言,开源大模型的学习曲线往往较为陡峭,涉及复杂的环境配置、模型部署和微调技术。针对这一痛点,Datawhale 团队精心打造的《开源大模型食用指南》项目应运而生,为中国开发者提供了系统性的学习路径。

该项目专为中国开发者量身定制,基于 Linux 环境设计,涵盖了从基础环境配置、本地模型部署,到全参数微调和高效 LoRA 微调,再到多模态大模型应用的全流程教程。项目支持包括 ChatGLM、Qwen、InternLM 和 LLaMA 在内的多个主流开源大模型,使得普通学生和研究者在没有深厚技术背景的情况下也能轻松上手。

项目核心特色

该项目提供了详尽的 Linux 环境搭建指导,针对不同模型的特点进行了专门优化。无论是初学者还是有经验的开发者,都能找到适合自己的配置方案。项目还包含了国内外热门开源大语言模型的部署与使用教程,从基础概念到实际操作,循序渐进地引导用户掌握核心技能。

在应用层面,该项目覆盖了命令行调用、在线演示和 LangChain 集成等多种使用场景,确保用户能够在不同环境中灵活运用大模型。对于希望深入研究的开发者,项目提供了完整的全量微调与高效的 LoRA 微调方案,这些内容特别适合希望在大模型领域深入发展的学习者。

实践导向的学习体验

该指南最大的亮点在于其实践导向的设计理念。通过丰富的实际案例,学习者不仅能够理解理论知识,更能亲手打造专属的私域大模型。这些案例涵盖了从数据处理、模型训练到部署应用的全过程,为用户提供了宝贵的实战经验。

无论你是刚刚接触大模型的新手,还是希望深入研究微调技术的开发者,这个项目都能为你提供最实用的指导。其系统性的内容安排和循序渐进的学习路径,确保每位学习者都能在开源大模型的海洋中找到自己的方向,实现从理论到实践的完美过渡。