MCP Client for Ollama 本地 LLM 开发利器

MCP Client for Ollama:本地LLM开发工具,支持多服务器并行、实时流式响应、工具管理及性能监控,提升开发效率与安全。

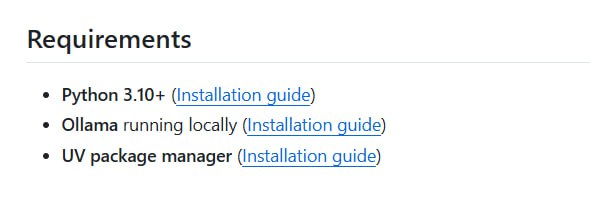

MCP Client for Ollama 是一款专为本地大语言模型开发者设计的终端工具,它通过集成 Model Context Protocol(MCP)实现了与多台服务器的便捷连接,支持高级工具调用与自动化工作流构建。该工具不仅提升了开发效率,还增强了本地模型与外部工具之间的协作能力。

在连接能力方面,MCP Client for Ollama 支持多服务器并行运行,兼容 STDIO、SSE 以及 Streamable HTTP 等多种主流传输协议,适应不同开发环境的需求。其终端界面采用现代化交互设计,集成模糊自动补全和高亮 JSON 工具展示功能,让操作更加直观高效。

该工具具备实时流式响应能力,用户可以在不重启服务的情况下灵活切换不同的本地 Ollama 模型,并动态调整上下文窗口大小。在工具管理方面,提供完整的服务器与工具启停控制,并引入 Human-in-the-Loop 机制,确保每次工具调用的安全性与可控性。

MCP Client for Ollama 还支持思考模式可视化,能够清晰展示模型的推理过程,目前已兼容包括 qwen3 和 llama3 在内的多款主流大语言模型。在开发调试过程中,支持服务器配置的热重载,用户无需中断当前会话即可应用新的配置变更,同时所有状态与偏好设置会自动同步。

配置持久化是该工具的另一大亮点,用户可以保存模型参数、工具状态、上下文管理策略以及各类性能指标的显示偏好。内置的性能监控模块会详细记录每次请求的响应时长、Token 使用数量及生成速率,为模型优化提供数据支持。

该客户端支持 Python 和 JavaScript 服务器,能够自动发现 Claude 配置,实现跨语言的无缝集成。基于 Typer 框架构建的命令行界面提供现代 CLI 体验,支持命令分组、Shell 自动补全以及详尽的帮助文档,大幅降低用户的学习成本。

MCP Client for Ollama 通过直观的交互设计和强大的功能集成,显著简化了本地大模型的工具调用与多服务器管理流程,为开发者提供了更加高效、安全的开发环境。

原文链接: MCP Client for Ollama