Karpathy nanochat 全流程 LLM 实现解析

Karpathy开源8000行代码LLM全流程项目:Rust高效训练、多任务微调、强化学习优化,支持轻量推理与工具调用。

近日,知名 AI 研究员 Andrej Karpathy 发布了令人瞩目的开源项目 nanochat,仅用不到 8000 行代码就完整实现了从训练到推理的大语言模型全流程。这一项目堪称开源界的宝藏,为大语言模型的开发与研究提供了全新的轻量级解决方案。

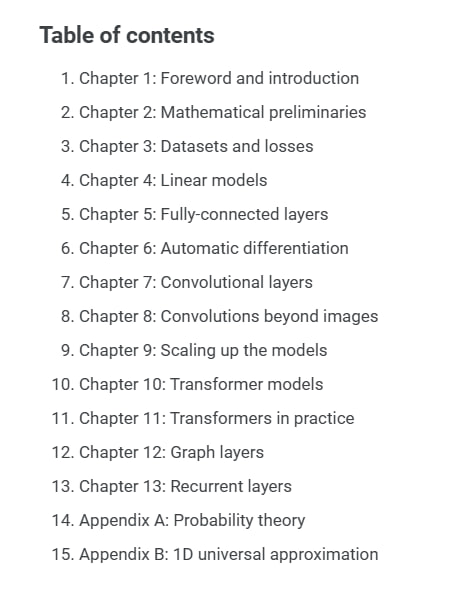

该项目采用 Rust 语言实现了高效的 tokenizer 训练模块,展现出卓越的性能表现。在 FineWeb 语料上,nanochat 完成了 Transformer 架构大语言模型的预训练,并对核心指标进行了多维度评估。训练过程中,项目创新性地结合了用户与助手对话、选择题解答、工具调用等多种任务类型,形成了丰富多样的训练范式。

![https://cdn.techfoco.com/images/2025-10/AQADGAxrGx1qiFd-_116001_862x685.jpg]

经过监督微调阶段后,该模型在多个权威测试集上表现优异。在世界知识评估方面,模型在 ARC-E 和 ARC-C 挑战赛以及 MMLU 大规模多任务语言理解测试中展现出强大能力。在数学推理领域,GSM8K 数学应用题数据集上的成绩令人印象深刻,而在代码生成方面,HumanEval 编程挑战的结果同样亮眼。

项目还提供了可选的强化学习方案,采用 GRPO 算法进一步提升模型在数学题目解答方面的能力。这种端到端的优化流程为模型性能的持续提升开辟了新路径。

在推理部署环节,nanochat 提供了轻量级推理引擎,完整支持 KV 缓存、预填充和解码等关键功能。特别值得一提的是,该项目集成了 Python 沙箱工具,既确保了安全性,又扩展了模型的实际应用能力。同时提供命令行界面和类似 ChatGPT 的网页用户界面,满足不同用户群体的使用需求。

模型架构设计同样值得关注,采用了类似 LLaMA 的稠密 Transformer 结构,配备 rotary 位置编码和 QK 归一化技术。嵌入层与反嵌入层保持独立,使用 ReLU² 激活函数的 MLP 层,所有线性层均不包含偏置项,整体设计简洁而高效。优化器方面结合了 Muon 与 AdamW 的优势,推理过程中还应用了 logit softcap 技巧来提升生成质量。

该项目生成的统一 Markdown 报告功能,为用户提供了便捷的模型评估、分数记录和游戏化体验,极大地改善了使用体验。对于希望从零开始理解大语言模型训练、调优和部署全流程的开发者和研究者来说,nanochat 项目提供了绝佳的学习和实践平台。

Karpathy 通过极简的代码实现展现了训练大语言模型的核心要素,突破了传统复杂框架的技术壁垒。Rust 语言的引入体现了业界对高性能和内存安全的追求,预示着未来大语言模型生态系统可能朝着更加轻量化、模块化的方向发展。

此外,项目中多任务训练与强化学习的有机结合,展示了大语言模型在实用场景中持续迭代优化的可行路径。对于广大开发者和研究人员而言,这样的开源工具显著降低了技术门槛,有望催生更多个性化、定制化的智能应用解决方案。

原文链接: Karpathy 最新项目震撼发布!不到 8000 行代码,完整实现了从训练到推理的 LLM 全流程,堪称开源界的宝藏