Easy LLM CLI:开源 AI 命令行工具

开源多模型AI agent,支持Gemini/OpenAI,提供大上下文窗口与多模态能力,简化开发运维流程。

在人工智能技术快速迭代的今天,如何高效地将大型语言模型集成到开发流程中,已成为许多开发者关注的焦点。Easy LLM CLI 作为一款开源的多模型兼容 AI 代理工具,致力于为开发者和技术团队提供强大且灵活的命令行 AI 解决方案,显著提升日常开发与自动化任务的效率。

Easy LLM CLI 支持包括 Gemini、OpenAI 以及任何兼容 OpenAI API 格式的自定义大语言模型。这意味着用户可以在不同模型之间轻松切换,无需更改既有的操作习惯,极大增强了工具的适应性和可扩展性。无论你使用的是云端商业模型,还是本地部署的开源模型,都可以通过统一的接口进行调用和管理。

该工具具备处理超长上下文的能力,能够查询、阅读甚至编辑大型代码库,帮助开发者更高效地进行代码理解与重构。无论是梳理遗留系统、执行大规模代码迁移,还是进行跨文件的逻辑关联分析,Easy LLM CLI 都能提供可靠支持。此外,它还集成了多模态处理能力,支持从 PDF 文档或设计草图直接生成应用原型,这一特性尤其适用于快速原型构建和自动化文档处理场景。

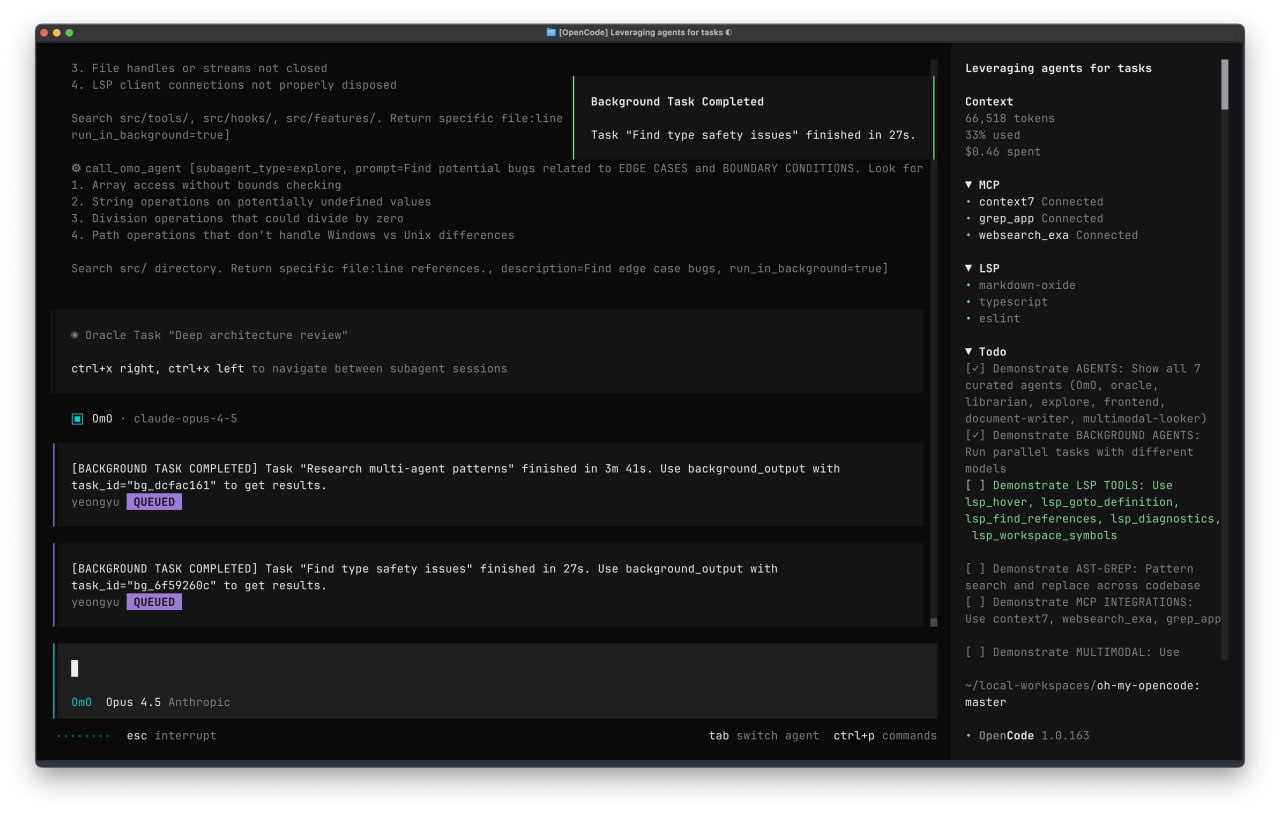

在运维自动化方面,Easy LLM CLI 能够处理诸如 PR 查询、复杂 rebase 操作、日志分析和系统监控等任务。通过与工具集成模型及 MCP 服务器的扩展能力,它可以无缝连接本地开发工具和企业级协作套件,帮助用户构建高度个性化的自动化流程。

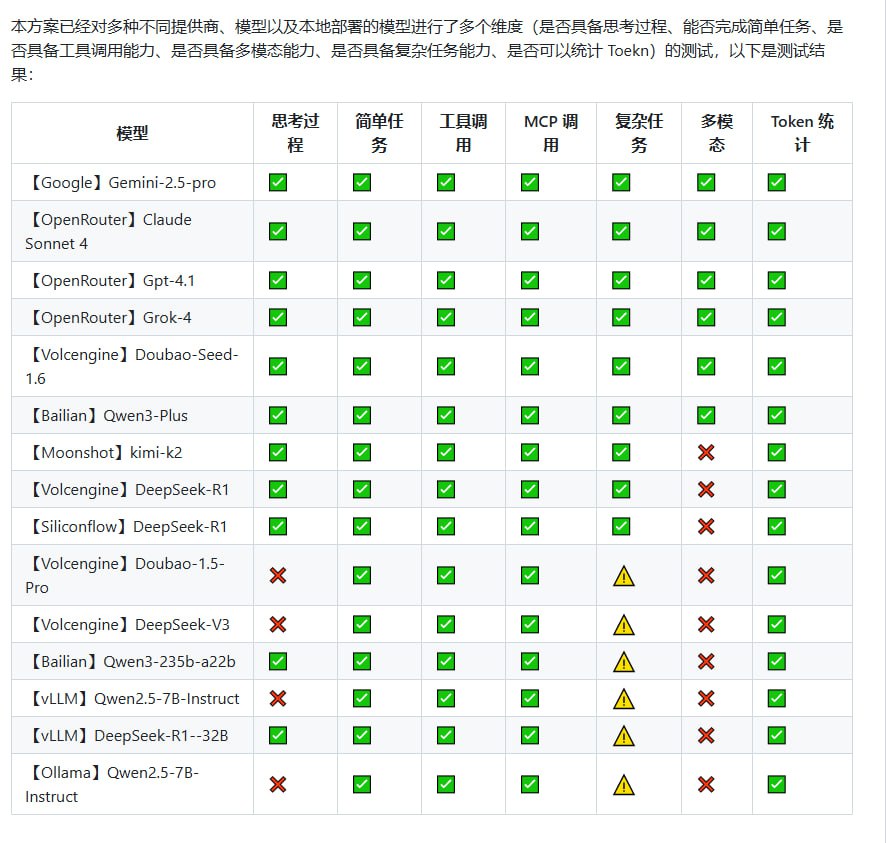

配置方面,Easy LLM CLI 设计极为简洁,仅需通过环境变量即可完成主要设置,降低了使用门槛。同时,它还提供多维度的模型测试支持,包括链式思考测试、多任务复杂度评估、工具调用验证和 Token 使用统计等,方便用户进行模型对比与性能调优。

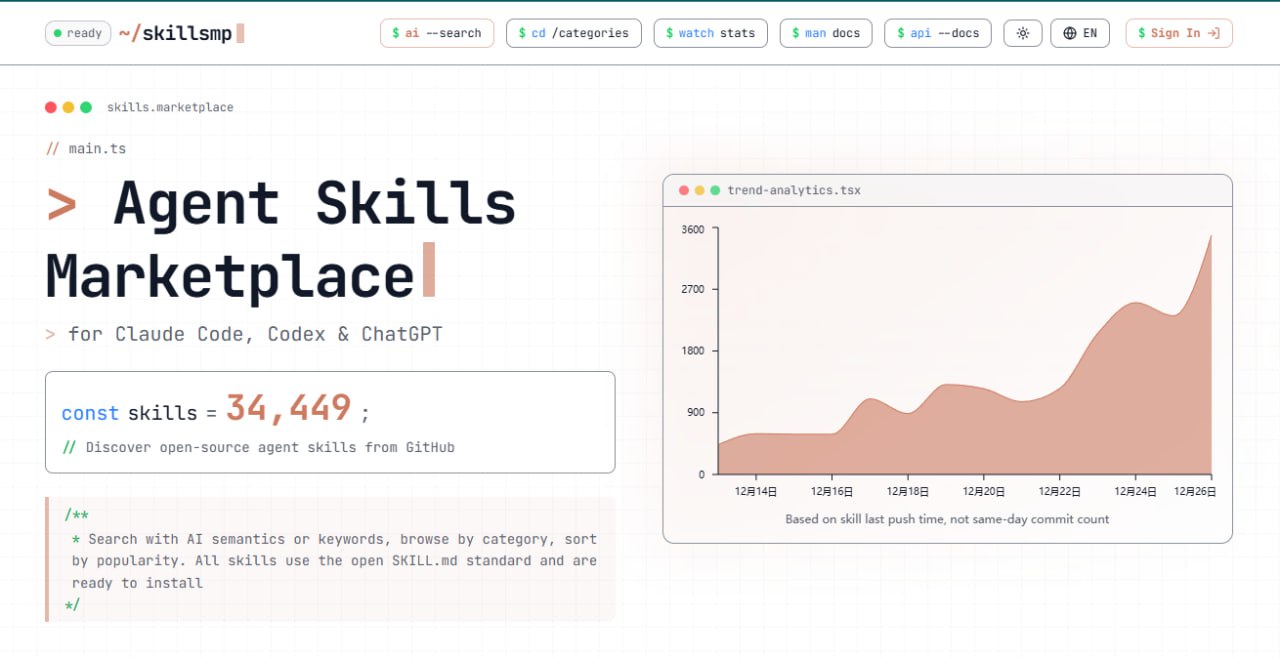

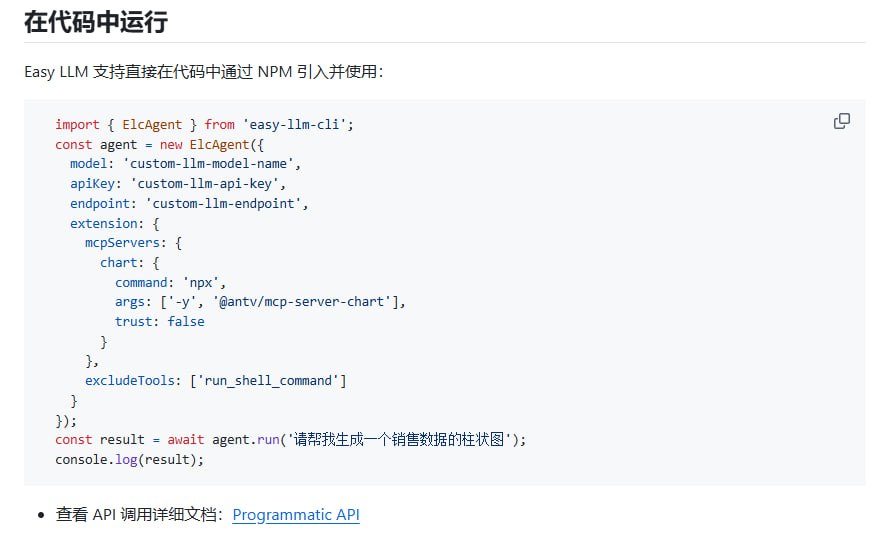

安装与集成同样便捷,用户可通过 NPM 快速安装并将其嵌入现有应用中。适用场景广泛,包括生成数据图表、自动化代码分析、项目初始化构建、文档生成和智能化辅助编程等。无论是个人开发者还是技术团队,都可以通过 Easy LLM CLI 快速构建出 AI 驱动的开发与运维工具链。

总的来说,Easy LLM CLI 以其模块化设计、强大的兼容性和低门槛的使用体验,成为现代开发者工具箱中一个值得关注的增强型工具。它不仅降低了 AI 技术的应用成本,更打开了命令行界面下自动化与智能化开发的新可能。

原文链接: Easy LLM CLI