谷歌 171 页 LLM 白皮书 技术全景指南

谷歌171页LLM白皮书:从Transformer到前沿架构,含源码解析与对齐技术详解。

曾发布经典 AI Agent 指南的谷歌高级总监再次推出重要技术文档,带来一份 长达 171 页的 LLM 白皮书。这份文档堪称目前最全面、最系统化的大语言模型学习资料,不仅涵盖基础理论,还包括前沿架构和代码实现细节,为研究者和开发者提供了一份宝贵的技术参考。

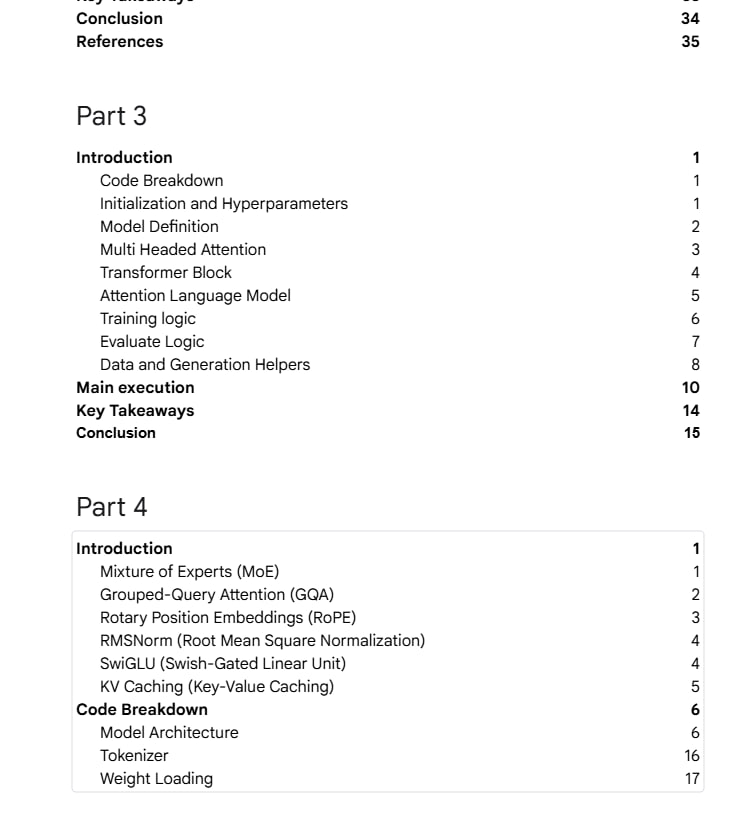

文档的第一部分深入探讨了大型语言模型的基础原理。从 Transformer 架构的开山之作《Attention is All You Need》讲起,系统性地解析了 Encoder 与 Decoder 结构、多头注意力机制以及 Scaling Laws 等核心概念。此外,该部分还延伸讨论了上下文窗口管理、混合专家模型(MoE)以及多模态融合等现代架构关键技术,为读者建立完整的理论基础。

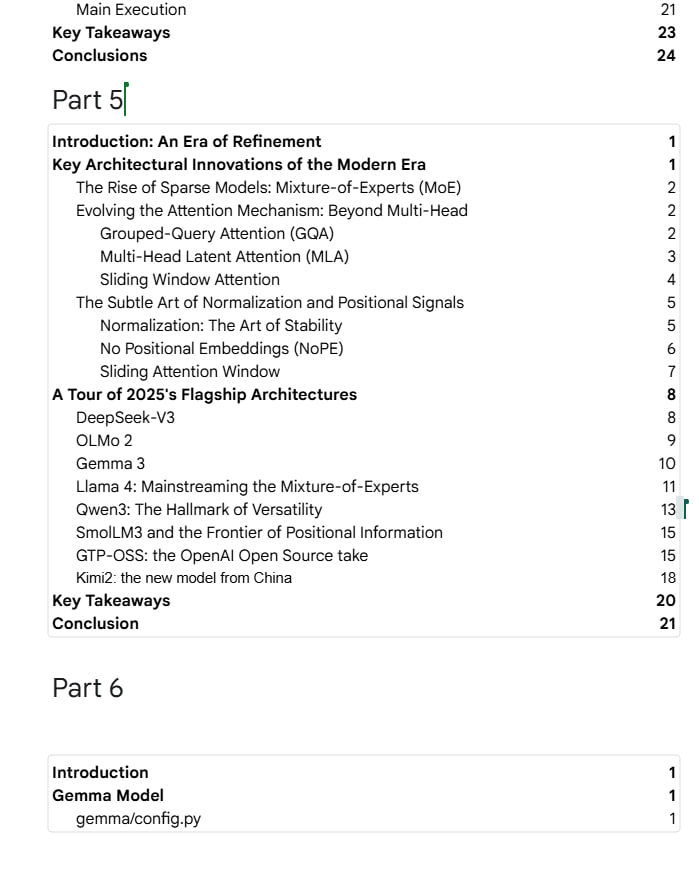

在推理与对齐部分,文档系统性地梳理了从思维链(CoT)到思维树(ToT)的高级推理范式演进过程,并详细解析了 RLHF、RLAIF 和 DPO 等关键对齐技术的原理与实现。这些内容不仅帮助读者理解模型如何逐步学会“思考”,还揭示了如何使大语言模型与人类价值观保持一致的重要方法论。

文档的技术实现部分尤为值得关注,不仅逐行解读了基础 Transformer 的代码实现,还对 MoE、分组查询注意力(GQA)、旋转位置编码(RoPE)和键值缓存(KV Caching)等现代 LLM 核心优化技术进行了原理与代码的双重分析。这些内容为工程师提供了可直接参考的实现方案,助力模型优化与部署。

在前沿架构与源码剖析章节中,文档全面评述了 2025 年各大厂商的旗舰模型架构,包括 DeepSeek-V3、Llama 4、Gemma 3 和 Qwen3 等代表性模型。特别地,作者以 Google 开源的 Gemma 3 为例,进行了源码级的深度解析,为读者理解最新模型架构提供了第一手资料。

总体而言,这份文档远超普通技术资料的范畴,它是一位资深从业者精心绘制的 LLM 技术全景图,既适合初学者系统学习,也为资深研究者提供了深入的技术参考。无论是对自然语言处理感兴趣的学生,还是从事 AI 产品开发的工程师,都能从中获得宝贵的知识和启发。