谷歌 Sequential Attention 技术解析:让 AI 模型又快又准

谷歌Sequential Attention技术通过序列化注意力权重选择特征子集,实现模型压缩与加速,同时保持准确性。

在人工智能模型规模日益膨胀的今天,如何在保持甚至提升模型性能的同时,显著降低其计算与存储开销,已成为推动 AI 技术广泛落地的核心挑战。谷歌研究院近期公布了一项名为 Sequential Attention 的技术,其目标直指这一难题:旨在不牺牲模型准确性的前提下,让模型变得更精简、运行更高效。这项研究为解决模型效率问题提供了一个兼具理论深度与实践潜力的新思路。

核心挑战:NP 难的“子集选择”问题

Sequential Attention 技术所要解决的本质问题,可以归结为“子集选择”。这个概念听起来或许有些抽象,但它几乎贯穿了深度学习模型优化的方方面面。例如,在进行特征选择时,我们需要从海量特征中筛选出最具信息量的一个子集;在模型权重剪枝中,目标是识别并移除冗余或贡献微小的参数子集;而在嵌入维度调优时,则是在寻找最优的维度子集。然而,这类子集选择问题在计算复杂性上被归类为 NP 难问题。这意味着,随着数据规模和模型复杂度的增长,试图通过穷举法找到全局最优解在计算上是不可行的。

传统的解决方案,如贪婪选择算法,虽然在实践中被广泛采用,但其代价极高。这类方法通常需要在每一步选择后,重新训练或至少重新评估整个模型,以确定下一个最佳候选,这导致了巨大的计算开销。因此,开发一种能够将选择过程高效地整合到模型训练流程中的方法,成为了一个迫切的需求。

技术原理:将选择嵌入训练的序列化注意力

Sequential Attention 的巧妙之处,正在于它创造性地将选择过程直接嵌入到模型的训练动力学之中。其核心机制是利用 注意力权重 作为衡量特征或组件重要性的代理指标。算法以序列化的方式运行:在每一步,它根据当前计算出的注意力得分,选出得分最高的候选(如某个特征或神经元),然后将其纳入已选集合。随后,模型会基于新的集合状态,重新计算剩余所有候选的注意力权重。

这种动态重评估机制使得算法能够天然地识别冗余。因为当一个高度相关的特征被选中后,与其强相关的其他特征的边际贡献(即额外带来的信息增益)便会显著下降,从而在后续步骤中获得较低的注意力分数。这与一次性计算所有注意力权重并做选择的传统方法有本质区别。Sequential Attention 采用的 序列化决策 过程,精准地捕捉了特征间复杂的非线性交互关系。在现实数据中,一个特征单独看可能价值有限,但与其他特定特征组合时却至关重要;反之,一个孤立看来很重要的特征,在整体上下文中可能完全冗余。序列化选择允许算法动态适应之前的决策结果,这是生成高质量、非冗余排序的关键。

实践成效与理论根基

在实际应用中,Sequential Attention 已经展现出令人瞩目的效果。在多项神经网络基准测试中,基于该技术的方法达到了最先进的性能水平。特别是在结构化剪枝任务上,其升级版 SequentialAttention++ 在 ImageNet 图像分类等挑战性任务中,实现了显著的模型压缩,同时成功保持了模型的预测准确性。

一个值得注意的理论联系是,当 Sequential Attention 被应用于简单的线性回归模型时,它在数学上被证明等价于经典的 正交匹配追踪 算法。这一等价性至关重要,因为 OMP 算法拥有严格的理论保证和可证明的可靠性。这为 Sequential Attention 在更复杂模型中的应用提供了坚实的理论根基,暗示其背后可能存在着普适的数学原理。

未来方向与社区反响

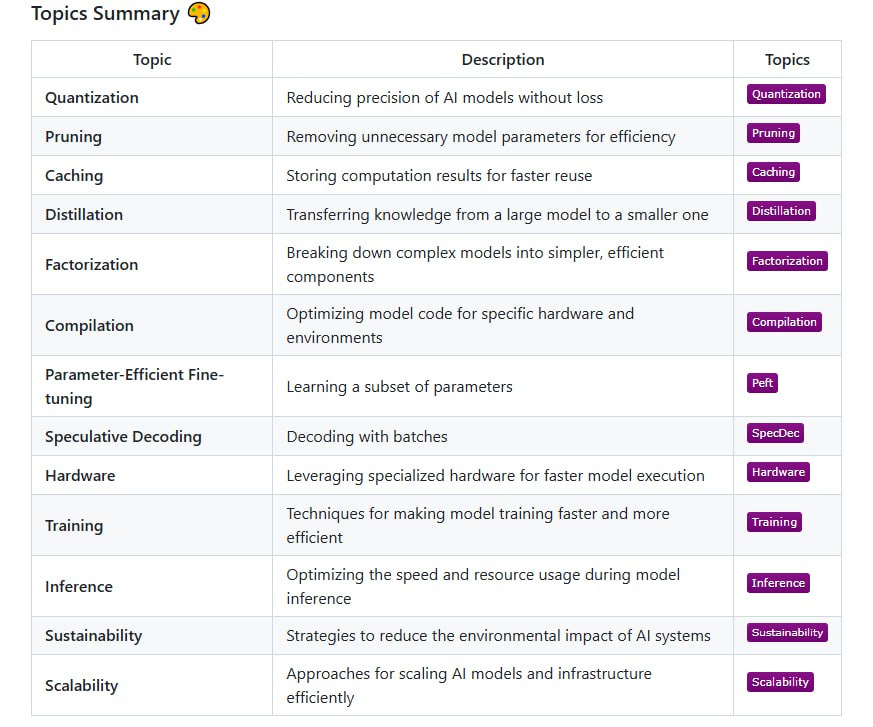

谷歌的研究团队指出了该技术几个颇具前景的未来应用方向:包括对大语言模型进行高效剪枝、优化推荐系统中的特征工程流程,以及在药物发现和基因组学等科学计算领域中的应用。其中,大语言模型剪枝 尤其受到关注。通过 Sequential Attention 框架,可以实现结构化的稀疏化,系统地剪除冗余的注意力头、嵌入维度,甚至是整个 Transformer 模块,从而为部署超大规模模型打开新的可能性。

技术社区对此项研究的反应呈现多元视角。有研究者指出,其核心数学概念的相关论文早在 2022 年就已发表,因此对其“新颖性”提出质疑。然而,最新的进展和贡献在于将这一理论概念成功应用于现代 AI 硬件架构和当今的大规模模型场景,并验证了其实际效能。同时,也有声音对这种方法在超大语言模型上的实用性表示关切,因为序列化的注意力计算过程可能引入额外的延迟,影响训练速度。

此外,一个需要清醒认识的关键点是:谷歌所宣称的“不牺牲准确性”,通常指的是在测试集上的性能表现与原始模型相当,而并非像 Flash Attention 这类优化那样保证计算结果的数值完全一致。这中间是否存在尚未被察觉的权衡或泛化差距,仍需在更广泛的任务和数据集上进行深入验证。

结语:效率优化成为 AI 发展的关键战场

模型效率优化正在成为人工智能发展的关键战场。当模型规模持续以指数级膨胀,如何用更少的计算资源、更小的存储占用和更低的能耗达到同等甚至更优的效果,将在根本上决定 AI 技术能否实现真正的规模化普及与实际部署。Sequential Attention 技术为我们提供了一个既有坚实理论支撑,又经过初步实践验证的创新思路。它代表了一种将模型架构搜索与训练过程深度融合的范式转变。至于这项技术最终能走多远,能否成为下一代高效 AI 模型的基石,还有待于其在开源社区的进一步检验、在不同领域的实际应用中的持续表现,以及后续研究的不断深化与拓展。