重复提示词:大模型性能提升的零成本技巧

重复提示词可显著提升大模型表现,原理是让每个token都能看到完整上下文,弥补单向注意力缺陷。

Google Research 近期发表的一项研究揭示了一个令人意外的发现:在不启用模型的推理模式时,只需将你的提示词原封不动地重复一遍,就能显著提升大语言模型在多种任务上的表现。这项研究为提示工程领域带来了一个近乎零成本的优化策略。

原理探析:弥补单向注意力的先天不足

其背后的原理直观而深刻。主流的大语言模型本质上是因果语言模型,其核心的 Transformer 解码器架构采用单向注意力机制。这意味着在生成每一个新的 token 时,模型只能“看到”并关注它之前的所有 token,而无法获取其后的信息。这种设计带来了一个关键影响:提示词中不同部分被模型“看到”的时机和上下文深度是不同的。

例如,当你采用“先提供背景信息,再提出具体问题”的提示结构时,模型在生成针对问题的答案时,已经完整地处理过背景信息。然而,如果结构是“先提问题,再给背景”,模型在最初理解问题时,背景信息尚未被纳入上下文窗口。重复整个提示词这一简单操作,巧妙地解决了这一问题。它相当于让模型在生成回答的每一个步骤中,都能在其有效的注意力窗口内,反复“看到”完整的指令和上下文信息,从而弥补了单向注意力机制带来的信息视野局限。

实证结果:广泛有效的性能提升

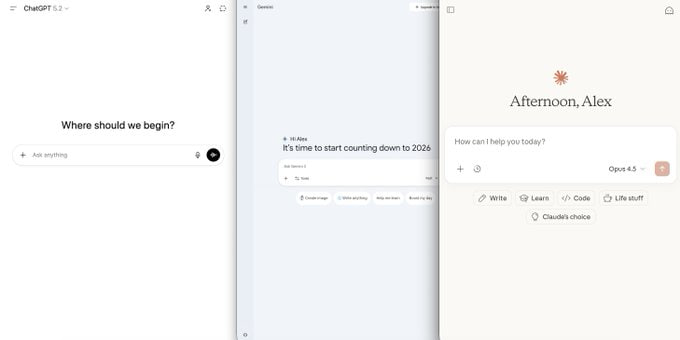

研究团队在包括 Gemini、GPT、Claude、Deepseek 在内的七个主流大语言模型上进行了系统性测试,任务范围覆盖了 ARC、GSM8K、MMLU-Pro 等多个权威基准。实验结果相当具有说服力:在总计 70 组对比测试中,采用提示词重复策略的设定赢得了 47 次,而输掉的次数则为 0。这证明了该技巧在不同模型和任务上具有广泛而稳健的正面效果。

实践优势:零额外开销的部署方案

这项技术最吸引人的地方在于其近乎零成本的特性。由于重复操作发生在模型推理的预填充阶段,而该阶段是高度可并行化的,因此 生成的 token 总数和用户感知的响应延迟并不会增加。模型的输出格式也保持不变,这意味着开发者可以将其作为一个透明的优化层,直接、无缝地集成到现有的应用系统中,无需修改后续的数据处理流程。

与推理模式的深层关联

研究中的一个有趣观察是,那些经过强化学习训练、擅长复杂推理的模型,在其内部思考过程中,往往会自发地学会重复或复述用户的问题。这暗示了“重复”可能是一种深层的、有效的认知辅助策略。本文探讨的提示词重复技术,在某种意义上可以看作是将这个“好习惯”从模型的内部推理过程,前置到了外部输入阶段,以一种更高效、更可控的方式实现了类似的效果。

变体分析与边界探索

为了深入理解其机制,论文还测试了几种变体。例如,将提示词重复三次在某些任务上能带来进一步的提升。然而,如果仅仅是用无意义的句号填充文本,使输入长度与重复提示词时相同,则完全无法产生任何性能增益。这有力地证明了,提升并非源于简单的文本长度变化,而是语义内容的重复本身在发挥作用。

此外,当用户主动启用“逐步思考”或“链式推理”等模式时,提示词重复的效果会变得从中性到略微正面。这符合我们的直觉,因为在这些模式下,模型自身的推理过程已经包含了对问题的分析和复述,外部重复的边际效用自然就降低了。

启示与展望

这项研究给我们带来的核心启示是:在追求复杂、精巧的提示工程技术之前,有时最简单、最直接的方法反而最有效。对于那些对响应延迟极度敏感、不适合开启完整推理模式的在线应用场景,将提示词重复作为一项默认的预处理策略,无疑是一个低成本、高回报的尝试方向。

论文也展望了未来十几个潜在的研究方向,例如探索只重复提示词中的关键部分是否足够,研究如何结合小模型对重复策略进行动态重排序,以及将该技术拓展到多轮对话的复杂场景中等。这个看似简单的发现,或许为我们打开了一扇新的窗口,让我们能以更细致的视角去理解和优化 Transformer 架构中的注意力机制。

原文链接: Google Research 最新研究揭示了一个简单到令人意外的技巧:在不启用推理模式时,把你的提示词原封不动重复一遍,大模型的表现就能显著提升。