Local Voice AI 本地语音助手全栈方案

Local Voice AI:开源全栈本地语音助手,整合ASR、LLM、TTS与RAG,支持一键部署,完全离线运行。

在人工智能技术日益普及的今天,语音助手已成为人机交互的重要入口。然而,构建一个低延迟、高隐私保护的本地语音助手通常面临诸多挑战。传统的实现方案往往需要独立配置语音识别、大语言模型推理以及语音合成等多个模块,复杂的集成过程与依赖管理让许多开发者望而却步。这种分散的架构不仅增加了部署难度,也可能引入额外的延迟和隐私风险。

正是在这样的背景下,Local Voice AI 作为一个全栈开源项目应运而生。它通过先进的 Docker 容器化技术,将语音交互所需的各个环节进行了深度整合,提供了一套开箱即用的完整本地化语音助手解决方案。该项目托管于 GitHub 仓库,由社区积极维护,旨在降低本地语音 AI 的应用门槛。

核心功能与技术架构

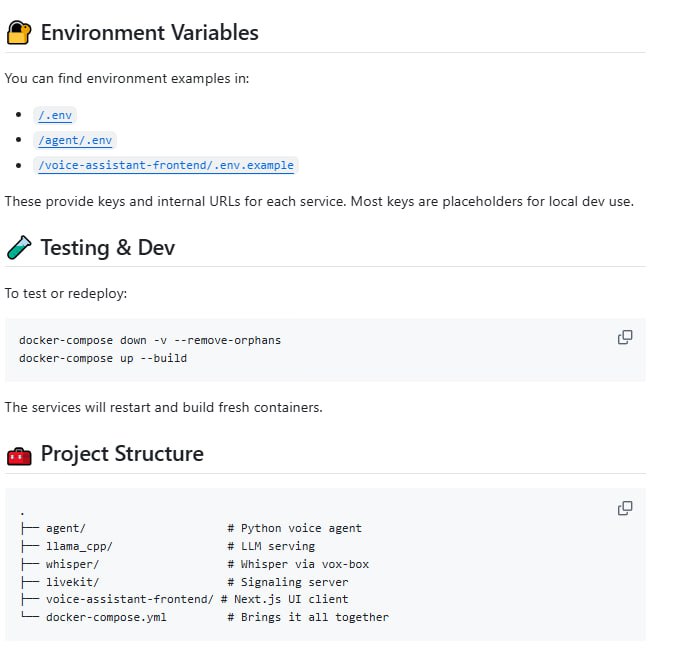

Local Voice AI 的核心价值在于其实现了从音频输入到语音输出的完整、流畅的实时对话闭环。整个处理链路完全在用户本地设备上运行,无需依赖任何外部云服务,这为对数据隐私有严格要求的应用场景提供了理想的基础。项目采用模块化设计,每个核心功能都封装在独立的容器中,通过 Docker Compose 进行编排,实现了环境的一键搭建与启动。

在语音识别环节,项目集成了业界知名的 Whisper 模型。该模型由 OpenAI 开源,以其高准确度和多语言支持能力而著称,为系统提供了可靠的实时语音转文字服务。转换后的文本会被送入后续的处理流水线。

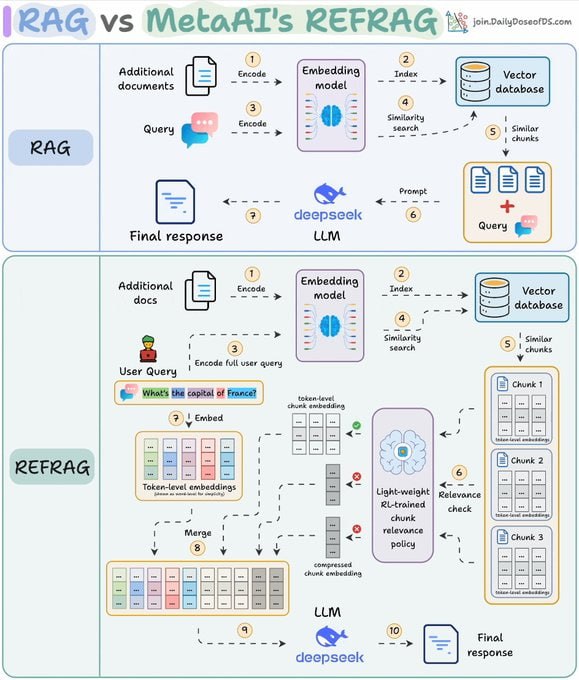

为了让 AI 的回复更具针对性和准确性,项目内置了检索增强生成 (RAG) 架构。该功能利用 FAISS 向量数据库和 Sentence Transformers 嵌入模型,能够对用户本地的文档(如 TXT, PDF, MD 等格式)进行索引和检索。当用户提问时,系统会先从本地知识库中查找最相关的信息片段,并将其作为上下文提供给大语言模型,从而生成基于特定知识的精准回复,极大地增强了语音助手的实用性和专业性。

语音合成方面,项目采用了 Kokoro 引擎来生成最终的语音反馈。Kokoro 能够输出自然且富有表现力的高质量语音,使得人机对话的体验更加亲切和生动。为了提供便捷的管理与交互界面,项目还配备了一个基于 Next.js 框架和 Tailwind CSS 开发的现代化 Web 控制台。该界面不仅支持发起语音对话,还能实时显示系统状态、处理流程以及 RAG 检索的源文档信息,让整个交互过程透明可视。

部署与适用场景

在部署友好性上,Local Voice AI 表现出色。其容器化的设计使得开发者无需在本地环境中手动安装复杂的 Python 依赖或配置深度学习框架,只需安装 Docker 和 Docker Compose,即可通过几条命令启动全部服务。项目对硬件的要求也较为友好,支持在纯 CPU 环境下运行,这降低了用户的使用成本。官方建议配备 12GB 以上的内存,以确保多个模型并行运行时的流畅性。

综上所述,Local Voice AI 是一个非常值得关注和尝试的开源项目。它特别适合以下几类开发者或团队:注重数据隐私、不希望语音数据离开本地设备的安全敏感型应用开发者;希望深入学习和研究本地 AI 模型集成与优化的技术爱好者;以及需要为内部系统构建一个定制化、离线语音交互功能的企业或研究机构。通过这个项目,开发者可以快速获得一个功能完备的起点,并在此基础上进行个性化的功能扩展与定制。