AI 论文追踪指南:Reddit 热议的实用策略

AI/ML研究者通过Google Scholar追踪作者与引用、关注顶会论文,并利用工具筛选。需接受无法读完所有论文的现实,建立信任名单并选择性阅读。

在人工智能与机器学习领域飞速发展的今天,新论文、新模型和新方法正以前所未有的速度涌现。对于每一位身处其中的研究者、工程师或学生而言,如何从信息的汪洋大海中精准、高效地捕捉到真正有价值的前沿动态,已成为一项至关重要的核心技能。近期,Reddit 的 r/MachineLearning 社区发起了一场热烈的讨论,众多从业者分享了他们在应对“论文过载”挑战时的真实策略与工具,揭示了学术信息追踪的现状与困境。

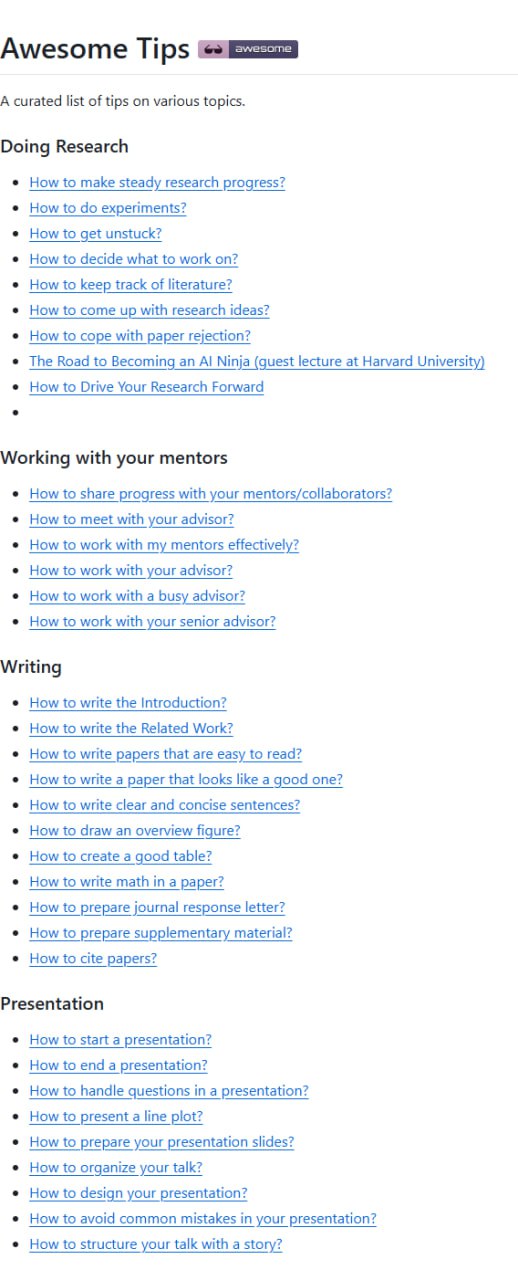

核心信息渠道:传统与新兴的博弈

尽管新兴平台不断涌现,但一些经典的工具和方法依然是研究者们依赖的基石。Google Scholar 的作者追踪功能被广泛认为是最高效的途径之一。通过关注你所在领域的关键学者和实验室,每当他们发表新作品时,系统便会自动推送通知,这相当于构建了一个个性化的学术信息流。此外,追踪那些具有奠基性意义的经典论文的引用情况也是一个聪明的策略,因为新的引用往往预示着相关领域出现了值得关注的新进展。

顶级学术会议,如 ICML、ICLR、NeurIPS 等,其录用论文列表依然是不可替代的高质量信息源。许多研究者会利用会议官网的关键词搜索功能,快速定位与自己工作相关的论文。更有甚者,会专门预留一整周的时间,系统性地浏览像 NeurIPS 这样大型会议所有论文的标题与摘要,以把握领域的整体脉搏。

与此同时,Twitter/X 在学术传播中扮演着一个复杂而微妙的角色。一方面,它无疑是获取最新论文预印本、研究动态和社区讨论的最快渠道之一,其算法会根据用户的关注和互动行为进行个性化推送。另一方面,平台上也充斥着对研究结果的过度简化或夸大解读,真正具有深度和专业洞见的内容反而稀缺。这种现状促使部分学者呼吁,学术界应尽快寻找或迁移到更专注于深度交流的替代平台。

实用工具推荐:让信息筛选更智能

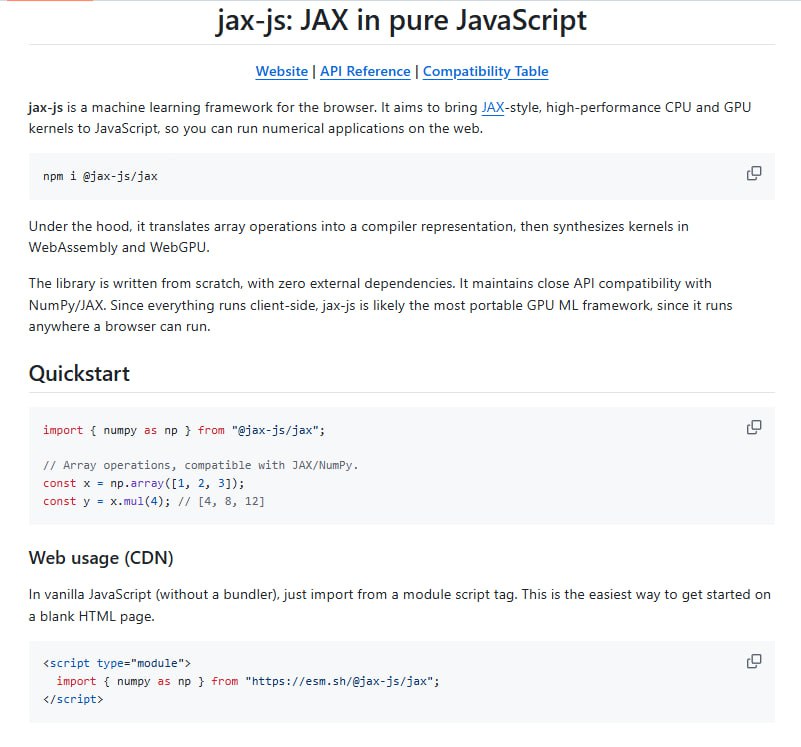

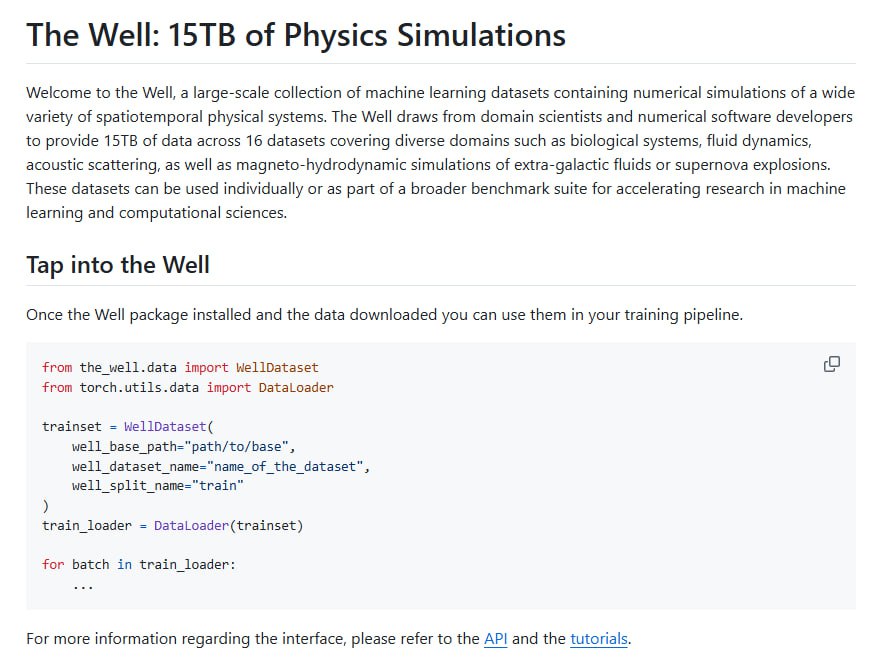

面对海量论文,借助一些智能化工具可以显著提升筛选效率。Scholar-inbox 是一个值得尝试的服务,它能够根据你设定的研究兴趣,每日推送相关的新论文,并附上算法生成的相关性评分,帮助用户进行优先级排序。Semantic Scholar 则提供了更强大的语义搜索能力,它不仅可以进行关键词检索,还能根据你收藏或阅读过的论文,通过语义理解来推荐你可能感兴趣的其他工作。此外,Paper Digest 提供了每日邮件订阅服务,它会将新论文进行排序并生成简洁的摘要,为用户节省大量浏览时间。

时间投入的现实困境与策略调整

讨论中透露出的一个残酷现实是:无论投入多少时间,似乎都难以跟上论文产出的速度。一位博士三年级的学生分享,他每周需要花费 10 到 12 个小时 专门用于阅读论文,即便如此,待读列表的长度仍在不断增长。为此,他开始尝试使用大语言模型来辅助进行论文的初步筛选,但效果仍在摸索和调试之中。

随着 2025 年论文数量预计将接近翻倍,筛选压力变得空前巨大。有从业者提到,他们不得不先使用严格的关键词组合将检索结果过滤到 1000 篇以下,然后再人工浏览标题和摘要。对于全职工作的业界研发人员而言,周末常常成为他们“补课”的唯一时间段。一位来自 Google 的员工坦言,即使在拥有顶级数据和算力资源的公司,大部分团队所做的也多是“名义上的机器学习工作”,例如大量的提示词工程和检索增强生成系统调优,真正从头训练新模型的机会并不多见。

务实的生存哲学:从全面覆盖到精准聚焦

在这种环境下,研究者们发展出了一系列务实的生存策略。一个被广泛认可的做法是:只重点关注那些其代码易于复现、实验可被重复验证的作者和实验室。与其试图覆盖所有新发表的工作,不如精心建立一个可信赖的“白名单”,深度跟踪这些高质量来源的产出。

另一种策略是扮演“二级读者”的角色:耐心等待你信任的、且有充足时间精力的同行先完成初步的筛选和评论,再根据他们的反馈来决定是否投入时间进行深度阅读。这本质上是一种基于社交网络的分布式信息过滤机制。

或许,最重要的心态转变在于坦然接受 “你不可能读完所有论文” 这一事实。将目标从“精读”调整为“知晓”——即通过快速阅读摘要和结论,至少了解某个方向存在哪些重要工作。当未来你的研究真正需要时,再回头进行深度挖掘。在这个信息过载的时代,明智地选择“不读什么”,往往比决定“读什么”更为关键。这场 Reddit 讨论最终达成的共识是,在追求前沿的同时,保持专注、建立信任网络并善用工具,才是可持续的学术成长之道。