医疗 AI 临床决策 稳定性 挑战

医疗AI决策不稳定:模型建议分歧大,同一问题回答一致性仅60%。需多模型对比验证,医生承担最终责任。

近期一项研究揭示,大型语言模型在医院临床决策中表现出显著的不稳定性,这为医疗 AI 的应用带来了新的难题。该研究对六款医疗相关模型进行了系统性测试,针对四个常见住院病例反复提问,结果显示不同模型对同一问题可能给出截然不同的建议。例如,在血液稀释剂使用决策中,约百分之五十的模型建议立即重新用药,而另外百分之五十则倾向于延迟观察。这种分歧凸显了模型之间缺乏一致性,进一步影响了其在临床环境中的可靠性。

同一模型在多次回答中的一致性仅约为百分之六十,意味着其输出结果可能出现反复翻转。绝大多数模型未能主动追问缺失的医疗信息,导致微小的措辞差异即可引发治疗方案的分歧。此外,不同模型在风险评估上各有侧重,有的关注出血风险,有的则更担忧肾损伤或早期出院后的潜在后果。值得注意的是,没有任何两款模型能在所有测试案例中保持答案一致,这暴露了当前医疗 AI 系统的局限性。

研究强调,大型语言模型更适合辅助构建框架选项,而非直接做出最终临床判断。临床医生在实际应用中应进行多模型对比,并通过反复提问来验证结果,同时始终承担最终决策责任。专家们在评论中普遍认为,这反映了当前模型训练和架构的固有局限,尤其是通用型大型语言模型缺乏专门的医疗数据训练。医学决策本身带有不确定性,医生在复杂病例中也会反复权衡和调整方案,因此 AI 的不稳定性并非完全意外。

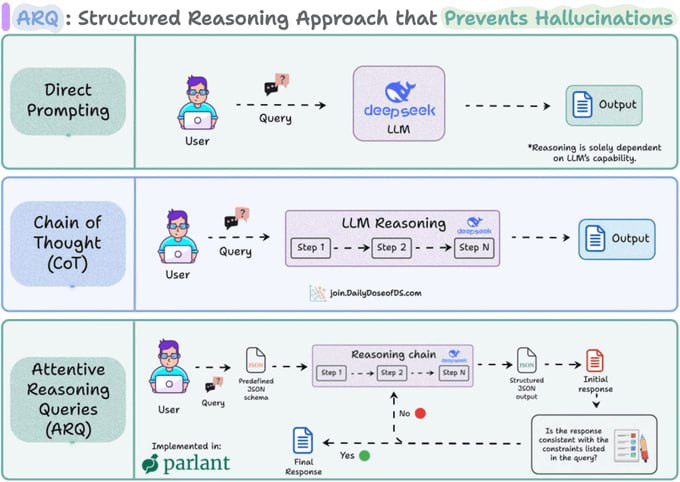

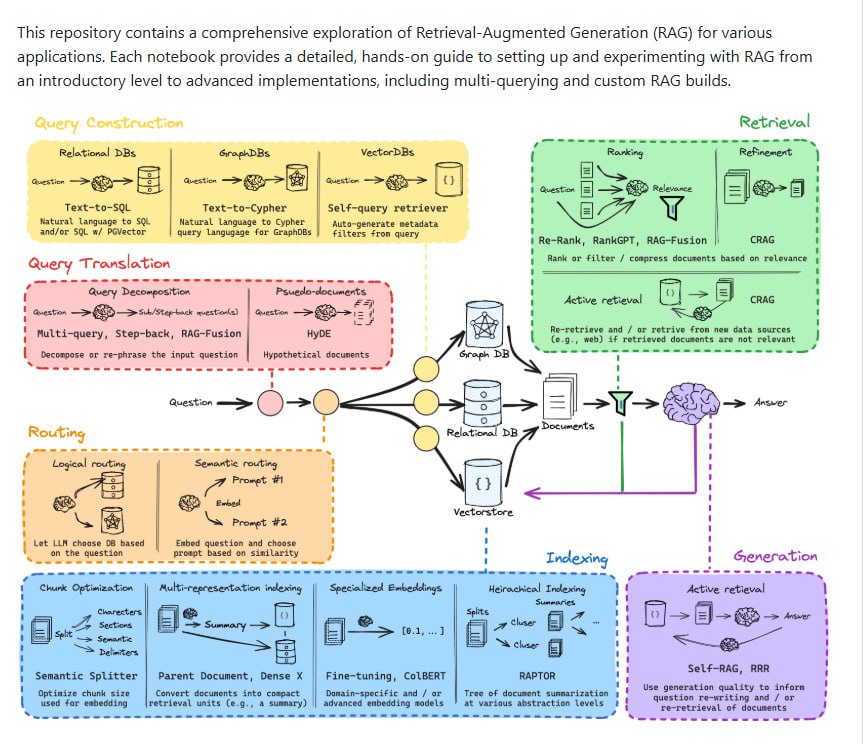

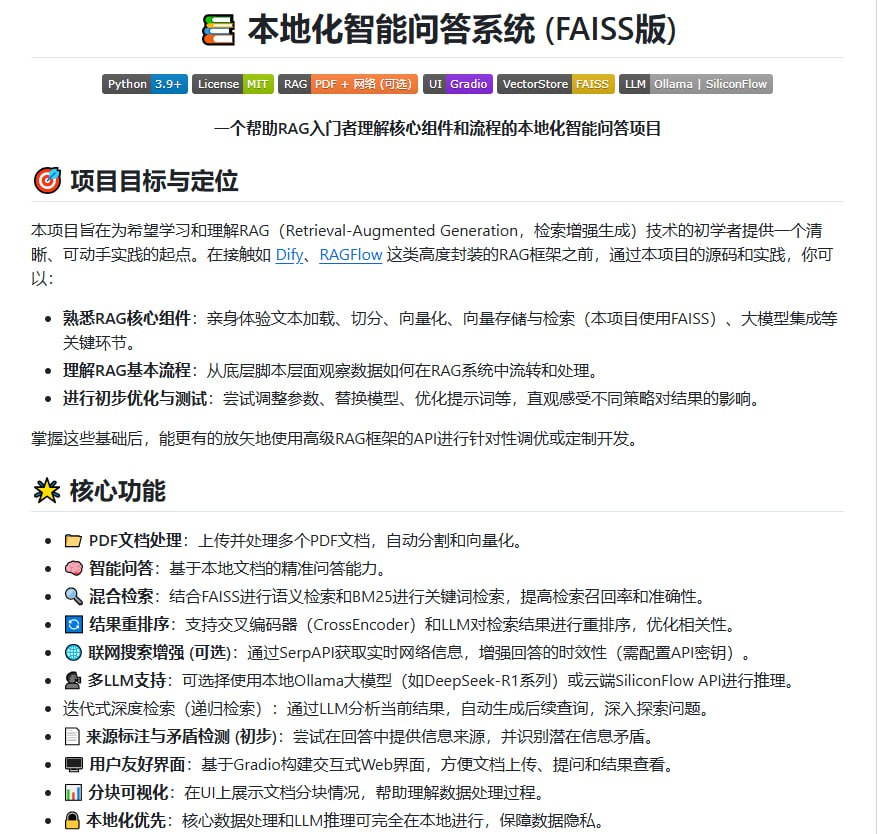

提升 AI 稳定性必须依赖更精准的训练方法、外部数据支持如检索增强生成技术,以及可审计的推理过程。研究虽然诊断了变异性的存在,但如何有效管理和利用这种变异性,才是未来面临的核心挑战。在当前阶段,AI 绝非临床决策的替代品,而应被视为辅助工具,帮助医生拓宽思路并提供参考。

医疗 AI 正处于探索期,它能够提出有价值的诊疗思路,但远未达到可完全信赖的成熟度。未来需要通过更多专门训练、严谨验证以及人机协同设计,来切实提升临床安全与治疗效果。随着技术的演进,我们期待看到更稳定、可靠的 AI 系统融入医疗实践,为患者 care 带来实质性改善。