RAG 系统实战:从关键词到智能问答

6周构建生产级RAG系统:从BM25关键词检索到本地LLM智能问答,集成OpenSearch混合搜索与Redis缓存,实现150~400倍性能提升。

在人工智能技术快速发展的今天,检索增强生成(RAG)系统已成为连接大型语言模型与专业领域知识的重要桥梁。本文将深入探讨如何构建一个完整的企业级 RAG 架构,从基础架构搭建到高级功能实现,全面解析每个关键环节的技术要点与实践方法。

系统架构与基础设施

构建生产级 RAG 系统的第一步是建立稳健的基础设施。我们采用 Docker 容器化技术确保环境一致性,使用 FastAPI 构建高性能的 API 服务层,PostgreSQL 作为结构化数据存储方案,OpenSearch 提供强大的搜索能力,再配合 Apache Airflow 实现工作流自动化调度。这套技术栈组合既保证了系统的可扩展性,又确保了生产环境的稳定性。

整个学习路径设计为六周的系统化进阶课程,循序渐进地引导开发者掌握 RAG 系统的核心构建技术。课程从基础设施搭建开始,逐步深入到自动化 arXiv 论文抓取与解析,再到生产级 BM25 关键词检索实现,最终完成智能文档切片与语义关键词混合检索系统的构建。

检索策略的核心设计理念

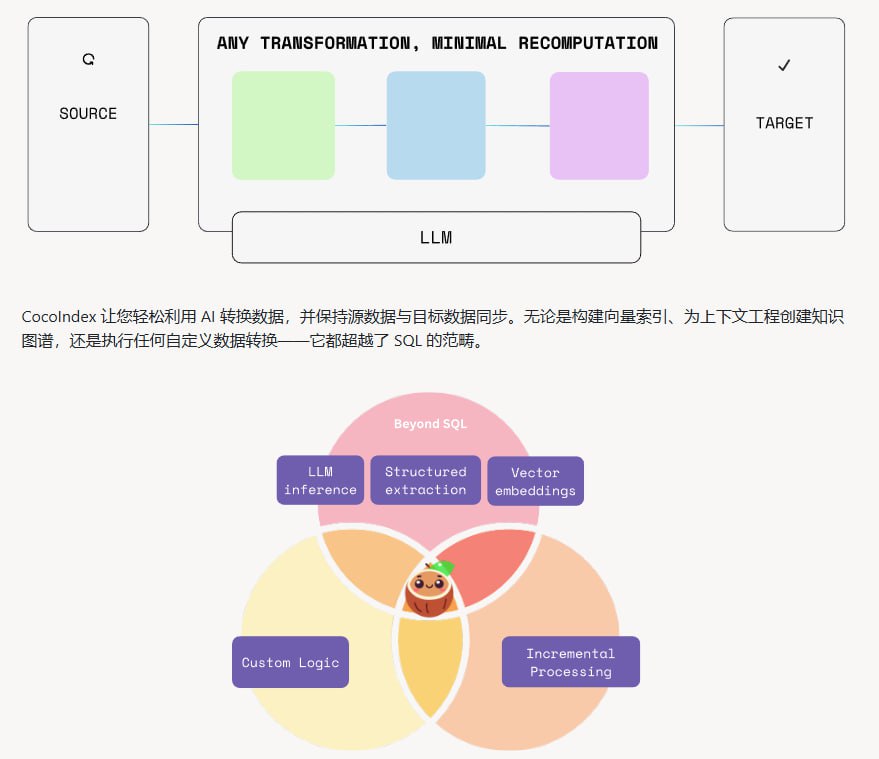

在检索策略设计上,我们强调关键词搜索是 RAG 系统的根基这一核心理念。首先需要打牢 BM25 精确匹配的基础,然后再引入向量语义检索,这种分阶段的方法能够有效避免单纯依赖向量检索带来的召回偏差和结果难以解释的问题。BM25 算法作为经典的文本检索算法,在关键词精确匹配方面表现出色,为整个检索系统提供了稳定的基础保障。

在建立稳健的关键词检索基础后,系统会引入语义检索层,形成混合检索架构。这种设计不仅提高了检索的召回率,还保持了结果的可解释性,让开发者能够清晰理解每个检索结果的来源和匹配原因。

本地化部署与性能优化

考虑到数据隐私和响应速度的需求,我们采用本地 Ollama LLM 实现方案,既保护了用户数据的隐私安全,又通过流式响应技术实现了秒级响应的用户体验。配合极简的 Gradio UI 交互界面,整个系统在保证功能完整性的同时,极大降低了使用门槛。

性能优化方面,我们集成了 Langfuse 实现端到端的请求跟踪,通过 Redis 缓存技术带来了 150 到 400 倍的响应加速,同时显著降低了系统运行成本。这种优化不仅提升了用户体验,也为系统的大规模部署提供了技术保障。

完整的工具链集成

系统集成了业界领先的工具链:使用 Jina AI 生成高质量的文本嵌入,Docling 实现科学 PDF 文档的精准解析,Apache Airflow 负责自动化任务调度,OpenSearch 提供强大的混合搜索能力。整个系统支持 Python 3.12 及以上版本,通过 Docker Compose 实现一键部署,极大简化了部署复杂度。

生产环境实践与监控

在生产环境配置方面,系统采用统一的 .env 配置文件管理,兼顾开发与生产环境的需求差异。实时性能与成本监控系统确保开发者能够及时了解系统运行状态,支持异常情况的优雅降级机制,保证系统在各种工况下的稳定可靠。

为了帮助学习者更好地掌握技术,项目提供了配套的 Jupyter 笔记本和详尽的技术博客,手把手指导构建真正可上线的科研助手系统。这套学习资源特别适合 AI 工程师、软件开发者和数据科学家深入掌握 RAG 工程的核心技术。

开源生态与扩展性

项目采用 MIT 开源许可,用户可以零费用在本地环境完整搭建整个系统,同时支持灵活接入外部 API 服务,具备高度的可扩展性。这种开源模式不仅降低了技术门槛,更为 AI 工程师构建未来的 AI 基础设施提供了坚实基础。

所有实现细节与代码示例完全公开,包括完整的架构设计和实操指导,开发者可以基于这些材料打造属于自己的 AI 论文智能助理,真正实现学以致用的教学目标。

原文链接: The Mother of AI Project