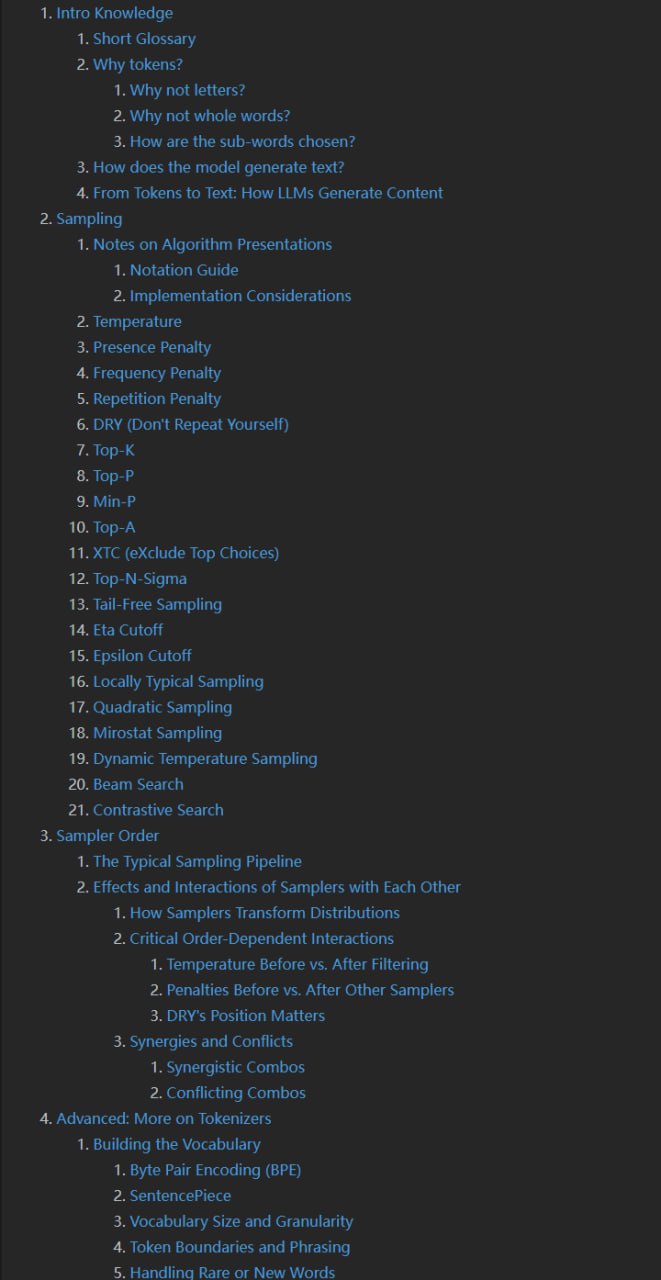

大语言模型采样 进阶指南

大语言模型采样指南:详解温度、Top-K、Top-P等策略组合,提升文本生成质量与多样性。

在自然语言生成领域,采样技术是决定文本输出质量的关键因素。本文将深入探讨大语言模型中各类采样方法的原理与应用,帮助开发者和研究者更好地理解和配置文本生成策略。

基础概念与分词机制

理解采样技术之前,我们需要先掌握语言模型的基本工作原理。现代大语言模型基于 Transformer 架构,通过自注意力机制处理输入序列并预测下一个最可能的 token。在文本生成过程中,模型会为词汇表中的每个可能的 token 计算概率分布,而采样策略正是从这个分布中选择下一个 token 的方法。

分词是文本处理的首要步骤,它直接影响模型的输入质量和生成效果。传统方法如 BPE(Byte Pair Encoding)和 SentencePiece 分词器通过统计学习将文本分解为子词单元,这种设计既解决了未登录词的问题,又控制了词汇表的大小。子词分词的优势在于能够平衡语义表达和计算效率,使得模型能够处理罕见词汇并减少内存占用。

核心采样策略详解

温度调节是最基础且常用的采样技术。通过调整温度参数,我们可以控制模型输出的随机性程度。当温度值设为较低水平时,模型会更倾向于选择概率最高的 token,生成结果更加确定和保守;而提高温度值则会平滑概率分布,增加输出的多样性和创造性。值得注意的是,极端温度设置可能导致生成质量下降,因此需要根据具体应用场景进行精细调整。

Top-K 采样通过限制候选 token 的数量来平衡生成质量与多样性。该方法仅从概率最高的 K 个 token 中进行选择,有效过滤了低概率的无关选项。这种策略特别适合需要保持话题相关性的场景,但若 K 值设置不当,可能排除合理的候选 token 或包含过多噪声。

Top-P 采样(又称核采样)是 Top-K 的改进版本,它根据累积概率动态确定候选集大小。这种方法能够自适应不同概率分布的特点,确保候选集始终包含足够的有意义选项。在实际应用中,Top-P 通常能提供比固定 K 值更灵活的生成控制。

重复惩罚机制专门针对模型可能陷入的循环生成问题。通过对已出现 token 施加惩罚项,降低其再次被选择的概率,该技术能够有效提升文本的多样性和信息密度。然而过强的惩罚可能导致关键信息的遗漏,因此需要谨慎调整惩罚系数。

策略组合与参数协同

单一采样方法往往难以满足复杂生成任务的需求,因此策略组合成为实际应用中的常见做法。温度调节通常作为基础设置,与 Top-K 或 Top-P 配合使用,形成多层次的采样控制体系。实验表明,适度的温度配合动态候选集选择能够在保持连贯性的同时激发模型创造力。

采样顺序对最终结果具有显著影响。不同的参数组合会产生截然不同的生成效果,这要求我们在实际部署中进行充分的测试验证。例如,先应用温度调节再执行 Top-P 采样,与反向顺序相比可能产生不同的文本特征。

参数协同优化是提升生成质量的关键。各采样参数之间存在着复杂的相互作用,需要系统性的调优策略。建议采用渐进式方法,先确定基础温度范围,再优化候选集参数,最后微调惩罚系数,通过多轮迭代找到最优配置。

实践建议与最佳实践

在实际应用中,选择采样策略应充分考虑具体场景需求。对于事实性内容生成,建议采用较低温度配合适度的 Top-P 设置;而在创意写作任务中,则可适当提高温度值并放宽候选集限制。同时,重复惩罚的设置应当与生成长度相匹配,长文本通常需要更强的惩罚力度。

监控与评估是优化采样策略的重要环节。建议建立系统的质量评估体系,结合自动指标和人工评价,持续跟踪不同参数配置下的生成效果。通过 A/B 测试比较不同策略组合,能够为特定应用找到最合适的采样方案。

随着大语言模型技术的不断发展,采样策略也在持续进化。新兴的采样方法如典型性采样和对比搜索等,为文本生成提供了更多可能性。保持对最新研究的关注,及时将先进技术融入实践,是提升生成质量的有效途径。

原文链接: 现代大语言模型采样入门指南