从零构建微型 vLLM 优化大模型推理

从零构建微型vLLM,拆解大模型推理优化关键技术,提供模块化代码教学。

在当今大语言模型 (Large Language Model, LLM) 应用蓬勃发展的时代,推理服务的性能与成本已成为决定其能否落地的关键。vLLM 作为一款备受瞩目的高性能推理引擎,以其卓越的吞吐量和高效的内存管理能力脱颖而出。然而,对于许多开发者和研究者而言,其内部复杂的技术细节如同一座黑箱,难以窥见全貌。本文旨在通过一个独特的视角——从零开始构建一个微型 vLLM——来深入解析现代大模型推理引擎背后的核心优化思想与工程实践。

理解推理引擎的优化挑战

传统的大模型推理流程往往直接调用模型权重进行自回归生成,这种方式虽然直观,但在处理批量请求或长序列时,会暴露出严重的性能瓶颈。核心问题主要集中在两个方面:一是 GPU 内存的利用率低下,大量显存被重复的中间状态和无效的缓存所占用;二是 计算资源的调度不高效,无法充分利用现代硬件的并行计算能力。vLLM 的成功,正是因为它系统性地解决了这些问题。

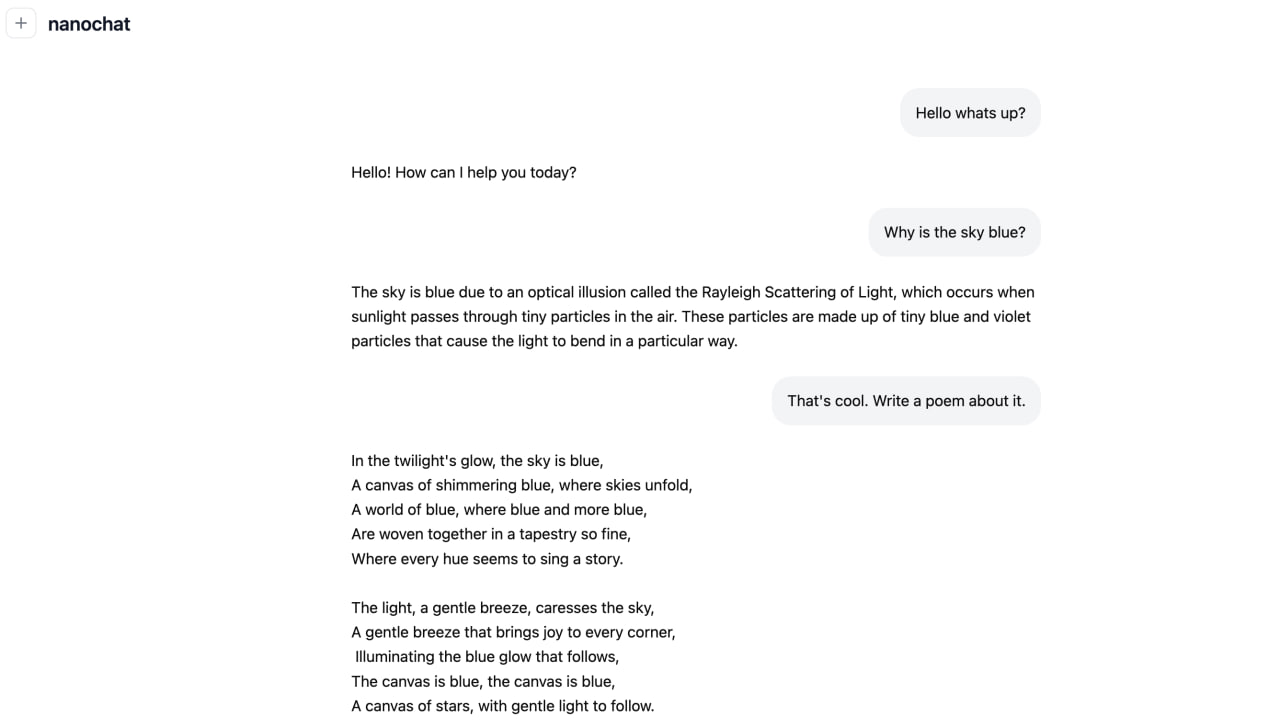

走进 nano-vllm:一个教学型实现

为了清晰地阐明这些优化技术,一个名为 nano-vllm 的教学项目应运而生。该项目并非旨在复现一个生产级的 vLLM,而是通过构建一个最小可行版本,将 vLLM 中那些关键但复杂的技术点进行模块化拆解。其代码结构清晰,每个模块对应一项核心优化,方便读者逐一对标理解。通过这种方式,抽象的优化概念变得触手可及。

核心优化技术剖析

首先,PagedAttention 是 vLLM 的灵魂所在。它借鉴了操作系统中的虚拟内存和分页思想,将注意力机制中的键值对 (Key-Value Cache) 从连续的物理内存分配,转变为离散的、按页管理的逻辑内存。这意味着不同序列的缓存块可以非连续地存储在显存中,从而极大地减少了由于序列长度差异和生成过程中的动态变化所导致的内存碎片。这就像为 GPU 显存引入了一个高效的内存管理系统,使得内存利用率得到质的提升。

其次,是高效的 请求调度与批处理 策略。在实际服务场景中,请求的到达是异步且不可预测的,它们的输入长度和所需生成的输出长度也各不相同。一个高效的推理引擎需要能够动态地将这些请求组织成计算批次,以最大化 GPU 的吞吐量。这涉及到复杂的调度算法,需要在延迟 (Latency) 和吞吐量 (Throughput) 之间取得平衡,并确保不同请求的计算图能够高效地融合执行。

此外,连续批处理 技术允许模型在生成一些序列的后续 token 时,同时为新的请求计算前向传播,从而让 GPU 保持持续忙碌的状态,避免了因等待而造成的计算资源闲置。这些技术共同作用,构成了现代高性能推理引擎的基石。

总结与启示

通过剖析 nano-vllm 这个微型项目,我们得以穿透复杂系统的表象,直接触及大语言模型推理优化的核心逻辑。优化并非魔法,而是对计算、内存和调度等基础资源的深刻理解与精巧设计。无论是 PagedAttention 对内存管理的革新,还是连续批处理对计算资源的极致压榨,其本质都是在解决冯·诺依曼架构下的经典瓶颈问题。对于希望深入 AI 系统工程或致力于优化自身模型服务的开发者而言,理解这些原理远比单纯调用一个封装好的 API 更有价值。读者可以通过研究其模块化代码,亲手实践,从而获得更深刻的认识。