可微编程入门:构建现代神经网络

《爱丽丝漫游可微仙境》是神经网络与可微编程的实践入门书,通过直观解释与PyTorch/JAX代码,讲解卷积、注意力等核心模块,帮助读者理解LLM等前沿模型。

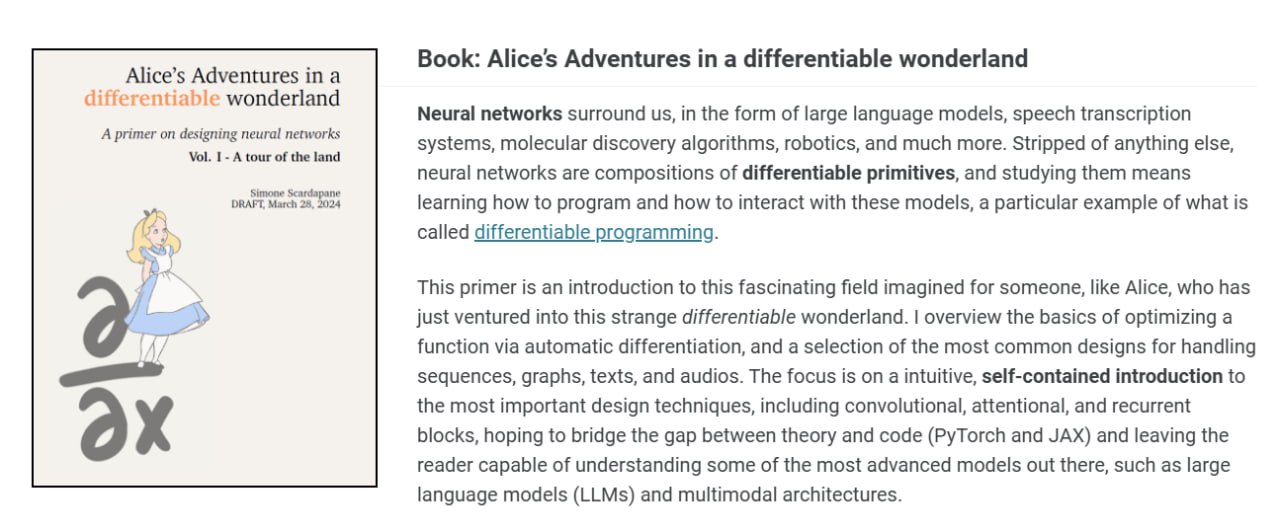

在人工智能浪潮席卷全球的今天,神经网络已成为驱动技术革新的核心引擎。从改写人机交互范式的大型语言模型,到精准的语音识别系统,再到加速科学发现的分子模拟算法,其身影无处不在。然而,这些看似复杂神秘的智能系统,其内核是否可以归结为更基础的构建单元?《Alice’s Adventures in a differentiable wonderland》一书给出了一个清晰而有力的肯定答案。这本书旨在为每一位如同爱丽丝般初探这片奇异可微仙境的求知者,提供一份直观且实用的地图。

作者的核心观点在于,剥开现代神经网络复杂的外衣,其本质不过是可微基元的巧妙组合。因此,学习和研究神经网络,实质上是在掌握一种名为 “可微编程” 的新范式——即如何通过可微分的操作来“编程”并引导模型的行为与优化。这本书的独特价值在于,它并非简单罗列概念,而是致力于在理论洞见与可执行代码之间架设一座坚实的桥梁。全书采用自成体系的叙述方式,聚焦于培养读者的技术直觉,并精选了处理序列、图结构、文本与音频数据时最核心的架构进行剖析。

本书的旅程从自动微分这一基石技术开始,详细阐述如何利用它来高效优化复杂函数。随后,读者将系统地学习现代神经网络中最重要的设计模块,包括但不限于强大的卷积块、赋予模型动态聚焦能力的注意力块,以及用于处理时序依赖的循环块。通过结合 PyTorch 与 JAX 两种主流框架的代码示例,读者不仅能理解这些模块的工作原理,更能亲手实现它们,从而为理解当今最前沿的大语言模型和多模态架构打下坚实基础。

令人兴奋的是,作者的探索并未止步于此。目前,该系列的第二卷已经开始撰写,并率先发布了一章关于强化学习的内容。这份技术文档内容详实,兼具历史视野与数学深度,系统性地讲解了强化学习在大型语言模型后训练中的关键作用。文档从奖励建模的基础概念出发,深入推导了策略梯度方法的原理,并逐步延伸到 PPO、GRPO 及 DPO 等当前最前沿的微调算法,揭示了其数学本质与应用细节。对于希望深入理解如何塑造和优化 AI 模型行为的读者而言,这无疑是极具价值的学习资料。

总而言之,《Alice’s Adventures in a differentiable wonderland》及其续作,代表了一种理想的技术入门路径:它从最基本的原理出发,通过直观的解释和可运行的代码,引导读者亲手搭建起通往 AI 核心的知识阶梯。无论是初学者还是希望巩固基础的从业者,都能从中获得深刻的启发与实用的技能。

原文链接: 爱丽丝漫游可微仙境:Alice’s Adventures in a differentiable wonderland