AutoDL 平台基础上的开源大模型使用和部署全流程指南

TechFoco 精选

本项目提供基于AutoDL平台的开源大型语言模型全流程教程,包含环境配置、本地部署、微调等技巧,适合想要使用或体验LLM的广大学生和研究者。

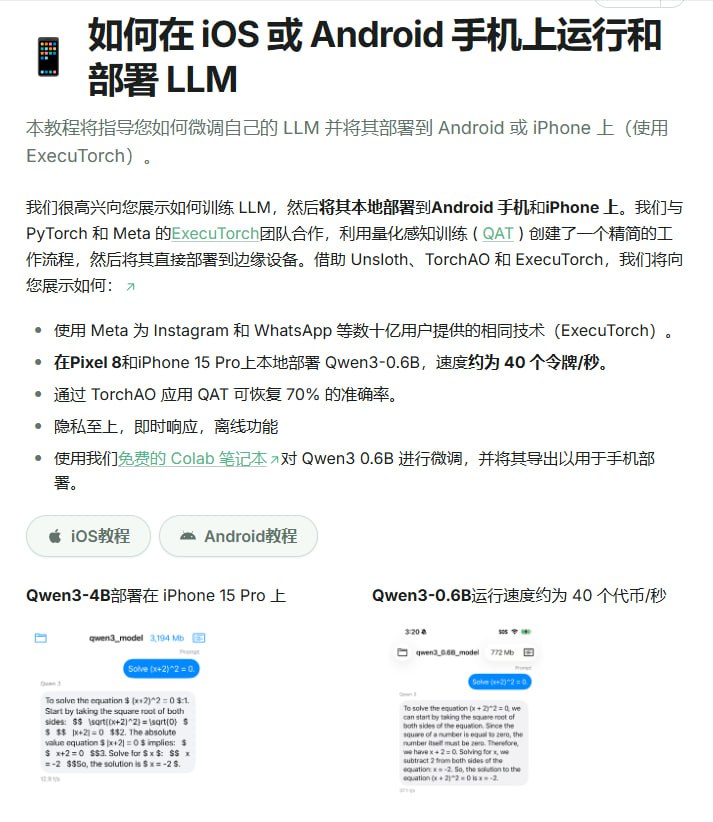

开源大模型使用指南 是一份帮助初学者更好地掌握和应用开源大模型的指南。它专为中国的学生和研究者设计,基于 AutoDL 平台,并可以扩展到其他平台,如阿里云。指南的主要目标是简化开源大模型的部署、使用和应用流程,使大模型更快地融入到广大学习者的日常学习生活中。

主要内容

开源大模型使用指南的主要内容包括但不限于以下几方面:

-

基于 AutoDL 平台的开源 LLM 环境配置指南:针对不同模型的特殊要求,我们提供了详细的环境配置步骤指导,使得学习者能够根据自己所使用的模型选择对应的环境配置。

-

开源 LLM 的部署使用教程:我们为国内外主流的开源 LLM 提供了一系列的部署使用教程,这其中包括的模型有 LLaMA、ChatGLM、InternLM 等。

-

开源 LLM 的部署应用指导:除了部署之外,我们还提供了一系列的应用指导,包括如何通过命令行调用模型、如何部署在线 Demo、如何将模型集成到 LangChain 框架中等。

-

开源 LLM 的微调方法:在模型的使用过程中,微调是必不可少的一个环节。因此,我们包括了一系列的微调方法,如分布式全量微调、LoRA、ptuning 等,以帮助学习者更好的针对自己的需求调整模型。

适用学习者

开源大模型使用指南适用于以下学习者:

- 希望使用或体验 LLM,但无条件获得或使用相关 API 的学习者;

- 希望长期、低成本、大量应用 LLM 的学习者;

- 对开源 LLM 感兴趣,想要亲自上手操作的学习者;

- NLP 的学习者,希望进一步掌握 LLM;

- 希望通过使用开源 LLM,构建出自己领域特色的私域 LLM 的学习者;

- 最广大、最普通的学生群体。

我们相信,开源大模型使用指南将帮助你更好地理解和使用开源大模型,在实践中提升你的技能和知识。