LLM 智能体:下一代编程语言

LLM智能体将编程语言抽象化,通过多智能体协作提升开发效率,核心在于管理指令而非代码。

一个大胆的假设正在技术社区中引发思考:如果说 C 语言之于汇编语言是一次抽象跃迁,Java 之于 C 语言带来了平台无关性,Python 之于 Java 进一步提升了开发效率,那么如今,基于大型语言模型的智能体正在对所有传统编程语言进行着同样深刻的重塑。这里的 LLM 智能体并非指单一的对话工具,而是一种全新的软件开发范式:多个具备不同角色的智能体并行协作,在大部分开发周期内自主运转,人类开发者仅在关键的设计决策或复杂问题介入点进行指导和审查。判断这一假设是否成立的标准非常直接:如果一位开发者借助多智能体协作模式,能够稳定地产出十倍于传统方式的可交付功能价值,那么这场变革就是真实发生的。站在 2026 年初的节点,虽然我们还不能对此做出完全确定的结论,但已有足够的迹象让我们必须严肃地思考这种可能性。

对于在软件行业深耕多年的从业者而言,质疑的声音自然不会缺席。首先,我们需要正面回应几个常见的反对观点。有人认为,十倍代码量绝不等于十倍产出,那可能只是堆积如山的低质量代码。这个批评切中要害,衡量的标准必须是实际交付的业务功能价值,而非简单的代码行数。如果前述假设成立,那么未来真正的“编程”行为,其核心将逐渐转变为精心设计给 LLM 智能体的指令与规范。另一种观点认为,LLM 工具主要是为不会写代码的人准备的。诚然,LLM 会极大地降低编程门槛,催生大量公民开发者,但这绝不意味着经验丰富的工程师无法从中获益。事实上,许多资深开发者正借助 LLM 实现个人生产力的阶跃式提升,将精力更多地聚焦于系统架构和复杂问题求解。还有人担忧,使用 LLM 是偷懒、不愿深入思考的表现。实际情况可能恰恰相反。当你指挥一支智能体舰队去完成一个庞大项目时,你需要进行的顶层设计、任务拆解和协调管理工作,其复杂度和所需的心智劳动远超亲手编写每一行代码。管理智能体意味着你要构思和设计的东西,在规模和抽象层次上都是原先的数倍。

关于编程技能退化的担忧也时常被提及。这种可能性确实存在,但历史早已给出启示:我们今天在工作中并不担心自己的汇编或 C 语言技能生疏,因为更高效的工具已经出现。大多数开发者只在特定场景或业余兴趣中练习这些底层技能,因为在商业环境中,已无人能证明用汇编写业务逻辑会比用高级语言更高效。同样,对于 LLM 生成代码质量不如人手的批评,也几乎可以肯定是对的。但这就像你的汇编代码质量可能远不及芯片专家一样,只要 LLM 生成的代码能够正确、高效地运行并满足需求,它就已经具备了交付价值。系统架构或许不够优雅,但功能可用性是第一位的。成本是另一个现实考量。有人觉得调用 LLM 智能体 API 过于昂贵。然而,如果它们能带来 50% 甚至更高的稳定生产力提升,相较于资深开发者的薪资成本,其投入产出比是相当可观的。并且,随着技术发展,LLM 服务的成本正在并持续快速下降,它们在绝对值上或许显得昂贵,但在提升价值的相对值上,正变得越来越经济。最后,关于“尝试了一下,感觉纯粹浪费时间”的挫败感,我们必须承认学习曲线的存在。回想一下,我们当初掌握第一门编程语言、第一个开发框架花费了多少时间,经历了多少与编译错误和诡异逻辑的搏斗,才最终勉强上手。掌握与智能体高效协作的新范式,同样需要投入与耐心。

上述反对意见在逻辑层面大多可以化解,但在情感和习惯上接受起来确实不易。真正触及这场变革核心的挑战,主要集中于两点:代码质量与系统可理解性。我们是否正在制造一个由 LLM 生成的、难以维护的“垃圾代码”废墟?我们是否在流沙之上构建软件大厦?另一方面,智能体可能产生的代码量会不会庞大到任何人都无法整体理解?即使系统能够运行,我们是否会因为丧失对内部逻辑的把握而永远失去对系统的控制权?我认为,质量和可理解性必须成为任何严肃的 LLM 编程框架或方法论的核心设计目标。从纯粹的经济学角度看,只追求“能跑”的质量是不够的,长期的维护成本会吞噬短期的开发效率收益。而可理解性,它或许带着一丝理想主义色彩,但也可能是一个值得全力押注的长期赌注——我选择相信后者。

有趣的是,LLM 本身比以往任何高级语言都更具非确定性和概率性。然而,它们也赋予我们一种前所未有的能力:在高层次的、接近人类语言的描述上,帮助我们理清复杂系统的思路和架构。这种在抽象层面进行协作和迭代的能力,是过去的编程抽象层从未真正实现的。

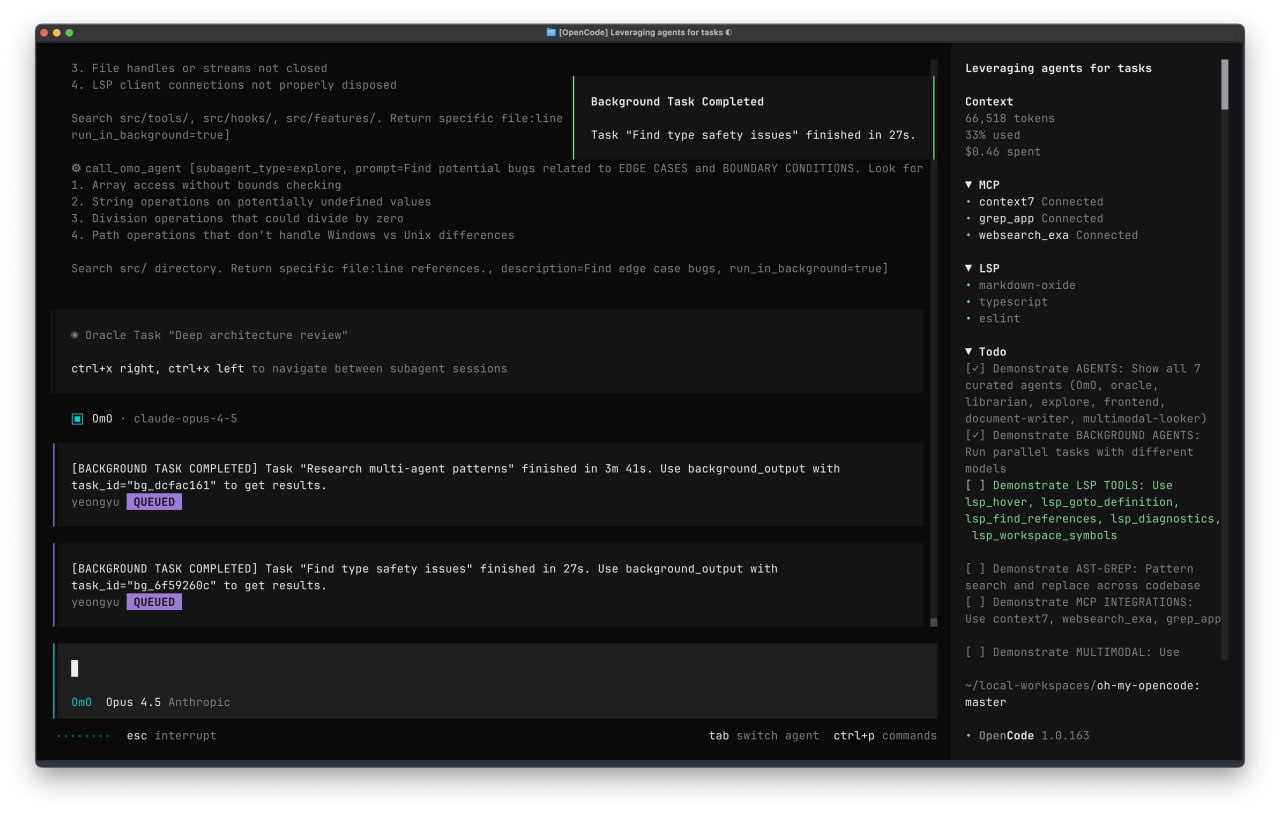

那么,未来的软件开发流程会呈现何种形态?我认为它将围绕四个核心要素展开。文档将不再仅仅是事后的补充,而是一组定义系统规格的活页,清晰阐述系统目的、核心实体、接口契约、业务约束、关键流程以及统一的编码规范。实现则包括最终的代码库与所有相关数据,理想状态下,整个代码库应该能够依据文档的描述进行重建或验证,而数据状态应与文档定义保持一致。对话记录了多个智能体在执行任务过程中产生的完整思考流、决策链和交互记录,人类可以随时透视或介入。任务则是驱动整个流程的离散工作单元,它们动态生成、可以嵌套,并带有完整的状态追踪。

这四个要素可以归纳为两个“存量”和两个“流量”。文档和实现是系统不断积累的知识与资产,是构建的成果;而对话和任务则是构建这些存量所发生的动态过程与活动。人类开发者当然可以直接修改文档和代码,但随着智能体驱动的工作流成为主流,这种直接干预会越来越少。人类的主要角色将转变为与智能体进行高层次交互,设定目标,并审核关键产出。

在这个生态中,智能体可以扮演多种专业角色:独立完成编码任务的执行者、协调任务流水线的管理者、千方百计试图破坏新功能的测试者、脱离原始上下文以全新视角审查代码的评审者,以及解决代码合并冲突的协调者。关键在于,人类可以灵活地配置这些角色,赋予它们的指令既可以是一次性的临时任务,也可以作为长期规范写入系统文档。

MCP 协议的出现,为解决长期存在的“应用孤岛”问题带来了革命性机遇。它可以被视作一种通用的数据与功能请求接口,允许你的智能体从任何现有软件系统(如 CRM、ERP、数据库)中安全地提取信息和功能,并将其整合到你自己设计的动态工作画布上。你可以直接告诉智能体“从 Salesforce 中提取本季度的客户数据并分析趋势”,LLM 驱动的智能体便会执行提取、处理,并在你指定的界面生成直观的可视化图表。这才是真正意义上的打破数据与功能壁垒。

如果我们选择构建在一個精良、稳固的底层技术基座之上,而非一个臃肿、复杂的技术栈,那么 LLM 需要生成和管理的代码量将大幅减少,系统的整体可理解性和可维护性也会显著增强。在这种架构下,系统的“前端”逐渐演变为交互式的文档和智能体操作界面,而“后端”则是一个强大而简洁的基座服务。

当然,许多开放性问题仍有待探索。例如,如何将动态的对话记录、版本化的文档与具体的代码实现关联存储?传统的 Git 版本控制系统如何适应这种以智能体生成为主、人机协作为辅的新开发模式?这些挑战正等待着开发者与研究者们共同去探索和解答。

原文链接: LLM智能体正在成为新一代高级编程语言