Opus 4.5 反馈:智能与稳健的平衡挑战

Opus 4.5反馈:需提升上下文智能、稳定性与UI体验,减少直觉错误,增强实用性。

近日,开发者 Alex Albert 在社交媒体上公开征集关于 Opus 4.5 模型的反馈,引发了技术社区的广泛讨论。用户们在积极肯定其强大能力的同时,也坦诚地指出了在实际应用中遇到的诸多痛点与改进空间。这些反馈不仅反映了当前前沿 AI 模型在落地时面临的普遍挑战,也为下一代模型的演进方向提供了宝贵的用户视角。

核心痛点:稳定性、智能与成本的三角难题

从用户反馈来看,当前 Opus 4.5 的使用体验受到几个关键问题的制约。最频繁被提及的是上下文长度限制带来的困扰。用户 Deedy 指出,过短的上下文窗口经常导致查询失败或界面出现空白,更令人沮丧的是,在切换页面后,先前辛苦输入的内容时常丢失,严重打断了工作流。这暴露了模型在长上下文管理与状态持久化方面的不足。用户们期望的不仅是更长的上下文,更是更强的“长上下文智能”——即模型能够主动提炼对话的核心主题与战略方向,进行有深度的综合与推理,而非仅仅充当一个被动的信息检索库。

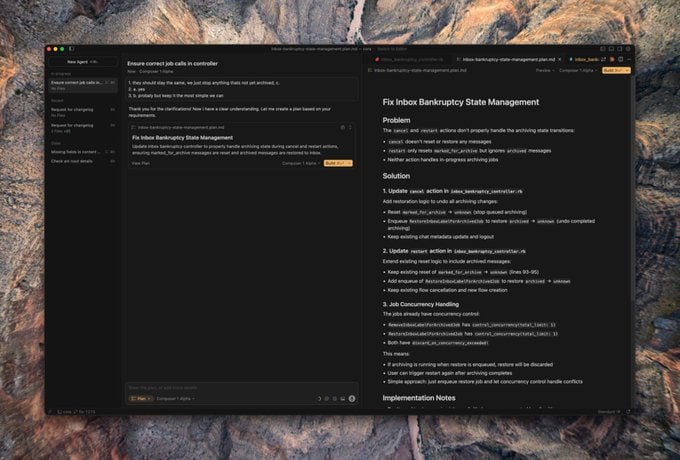

另一个突出问题是模型行为的不可预测性与“直觉化”倾向。不少用户反映,Opus 4.5 有时会过于急于得出结论,忽略指令中的关键细节,其回答显得依赖“直觉”而非经过严格的逻辑核查。这种表现上的波动性导致质量不稳定,有时甚至让用户感觉其表现比旧版本的 Sonnet 模型还要“迷糊”。在代码生成场景中,这一问题尤为明显:模型时常忽视项目中已有的抽象和工具函数,倾向于“重复造轮子”,并且在处理合并冲突时不够智能,往往需要等待 CI 流程失败后才能发现问题,降低了开发效率。

用户体验与功能集成亟待优化

在用户界面和交互体验方面,反馈同样指出了明确的改进方向。当前界面缺乏灵活性,例如用户无法在同一个会话中自由切换 Sonnet 和 Opus 等不同模型进行对比测试。自动上下文压缩功能对用户而言像一个黑盒,其行为不可控,有时会误压缩重要信息,反而浪费了用户调试和重新解释的时间与计算资源。用户强烈期待更精细的上下文管理工具,例如支持异步渐进式压缩,让用户能清晰知晓并控制哪些信息被保留或舍弃。

此外,用户对扩展新功能抱有很高期待。其中包括希望模型能够自动生成并维护项目中的 CLAUDE.md 类文档,使其随时保持最新状态;也期待未来能支持视频内容作为输入进行理解与分析,以应对更丰富的多媒体任务。在特定专业领域,如安全研究,用户指出模型当前的策略过于保守,会直接拒绝分析可能的恶意软件样本,缺乏在安全沙箱或可控环境下进行风险评估的智能,限制了其在专业领域的应用深度。

通往可信赖 AI 助手的道路

综合来看,Opus 4.5 无疑是一个功能强大的模型,但其在用户体验和技术细节上仍有显著的提升空间。这揭示了一个更深层次的行业挑战:如何在不断提升模型“强度”(即处理复杂任务的能力)的同时,同步增强其稳健性和实用性。真正的目标并非创造一个在基准测试中得分最高的模型,而是打造一个在日常工作中能够持续提供可靠、稳定、符合预期的助手。

这意味着需要减少模型“直觉式”的错误,增强其对复杂、冗长上下文的理解与记忆能力,并实现更优的成本与性能平衡。只有当 AI 能够理解用户的真实意图,稳定地执行任务,并智能地管理交互状态时,它才能摆脱偶尔“拖后腿的聪明伪专家”这一形象,进化成为用户真正信赖、不可或缺的生产力伙伴。社区的热烈反馈正是推动这一进化不可或缺的力量。