DeepSeek R1 模型构建全攻略:从 Qwen 到 SFT 的进阶之路

DeepSeek R1 模型构建指南:从基础模型 Qwen 到推理模型,使用 GRPO 算法和 SFT 提升推理能力,提供详细训练流程和手绘流程图,适合初学者。

在当今快速发展的人工智能领域,构建高效的语言模型已成为许多开发者和研究人员的关注重点。本文将深入探讨如何从头开始构建 DeepSeek R1 模型,这是一个基于 Qwen 基础模型的创新项目,通过 GRPO 算法和强化学习技术显著提升了模型的推理能力和语言一致性。

项目概述

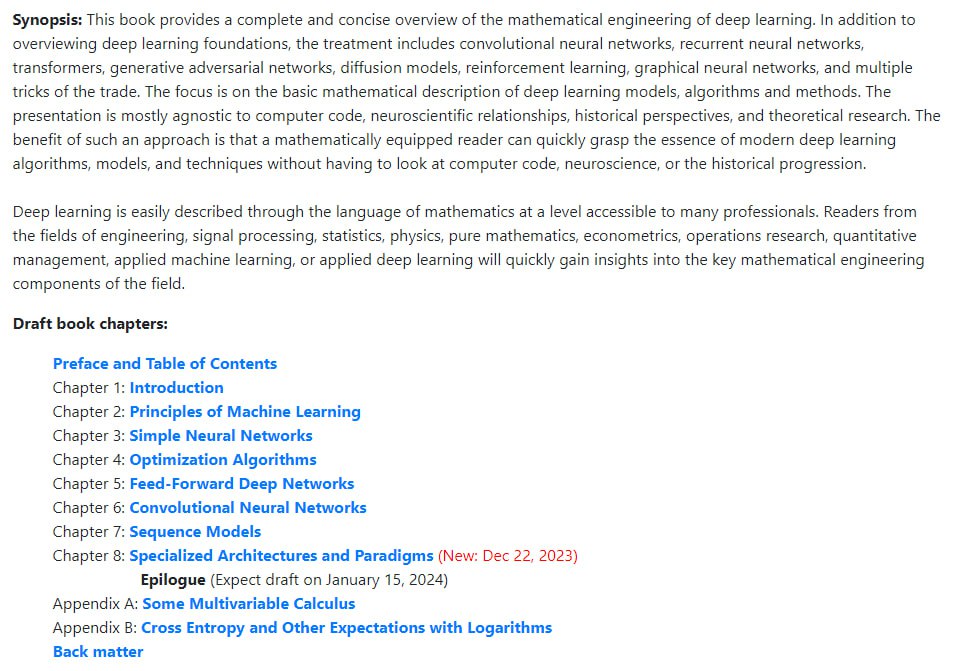

DeepSeek R1 是一个开源的语言模型项目,其完整代码实现可在 GitHub 仓库 DeepSeek R1 中找到。该项目的主要目标是通过系统化的训练流程,将基础模型转化为具有强大推理能力的智能系统。

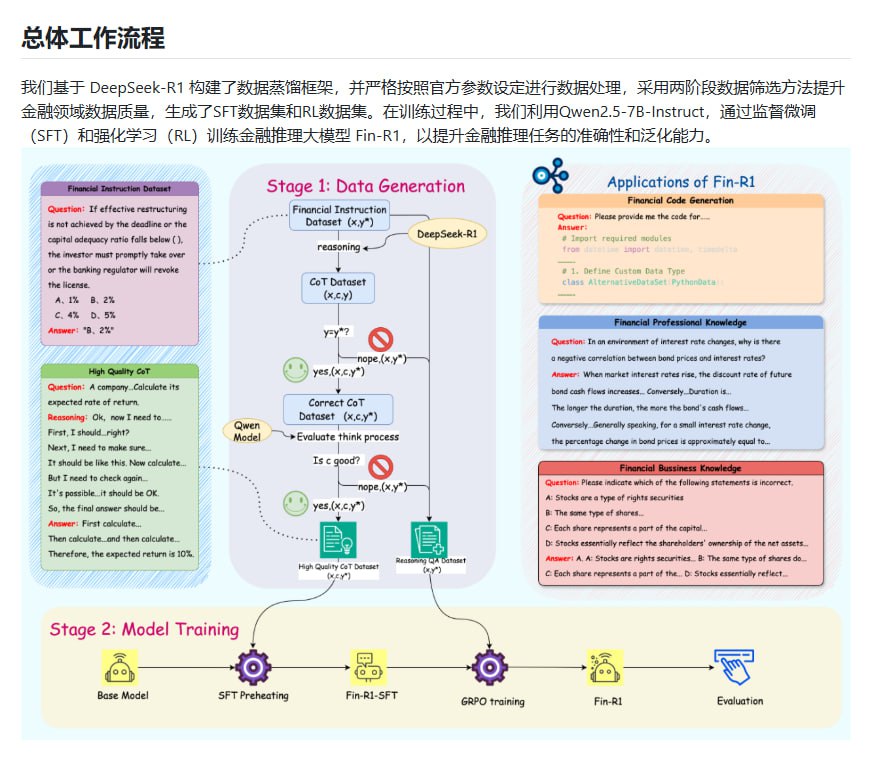

技术架构与实现

项目的核心架构基于 Qwen 基础模型,这是一个经过预训练的大型语言模型。我们首先对基础模型进行初步训练,然后通过 GRPO(Gradient Regularized Policy Optimization)算法进行优化。GRPO 是一种创新的优化方法,它通过引入梯度正则化机制,有效提升了模型在复杂推理任务中的表现。

在初步训练完成后,我们采用了监督微调(Supervised Fine-Tuning, SFT)技术。这一阶段主要使用高质量的人工标注数据,对模型进行精细调整,确保其输出符合预期的语言模式和逻辑结构。

强化学习优化

为了进一步提升模型的性能,我们设计了一套改进的强化学习方案。该方案通过引入奖励机制,鼓励模型生成更符合人类语言习惯的输出。具体来说,我们设计了一个多维度评分系统,综合考虑了语法正确性、逻辑连贯性和内容相关性等因素。

训练流程与效率优化

整个训练过程经过精心设计,确保即使是初学者也能轻松上手。我们提供了详细的训练指南和手绘流程图,帮助开发者理解每个步骤的关键要点。通过 GRPO 算法的应用,训练效率得到了显著提升,特别是在处理复杂推理任务时,模型的收敛速度明显加快。

实践建议与最佳实践

对于希望尝试 DeepSeek R1 的开发者,我们建议从以下几个方面着手:首先,仔细研究项目文档和代码结构,理解每个模块的功能;其次,在本地环境中进行小规模测试,熟悉训练流程;最后,根据具体应用场景调整模型参数,以获得最佳性能。

通过本文的介绍,相信您已经对 DeepSeek R1 的构建过程有了全面的了解。这个项目不仅展示了现代语言模型训练的最新技术,也为开发者提供了一个可扩展的框架,用于构建更智能、更高效的 AI 系统。