超越标准 LLM 的新兴架构解析

新兴LLM架构:线性注意力提升长序列效率,文本扩散加速生成,代码世界模型探索结构理解,小型递归变换器轻量高效。

在人工智能领域,大语言模型(Large Language Models)已经成为推动技术进步的重要力量。然而,随着应用场景的不断扩展和计算需求的日益增长,研究人员开始探索超越传统 Transformer 架构的新方向。Sebastian Raschka 最近发布的长篇技术博客《Beyond Standard LLMs》系统地介绍了几种具有潜力的新兴架构,这些创新正在重新定义自然语言处理的未来发展方向。

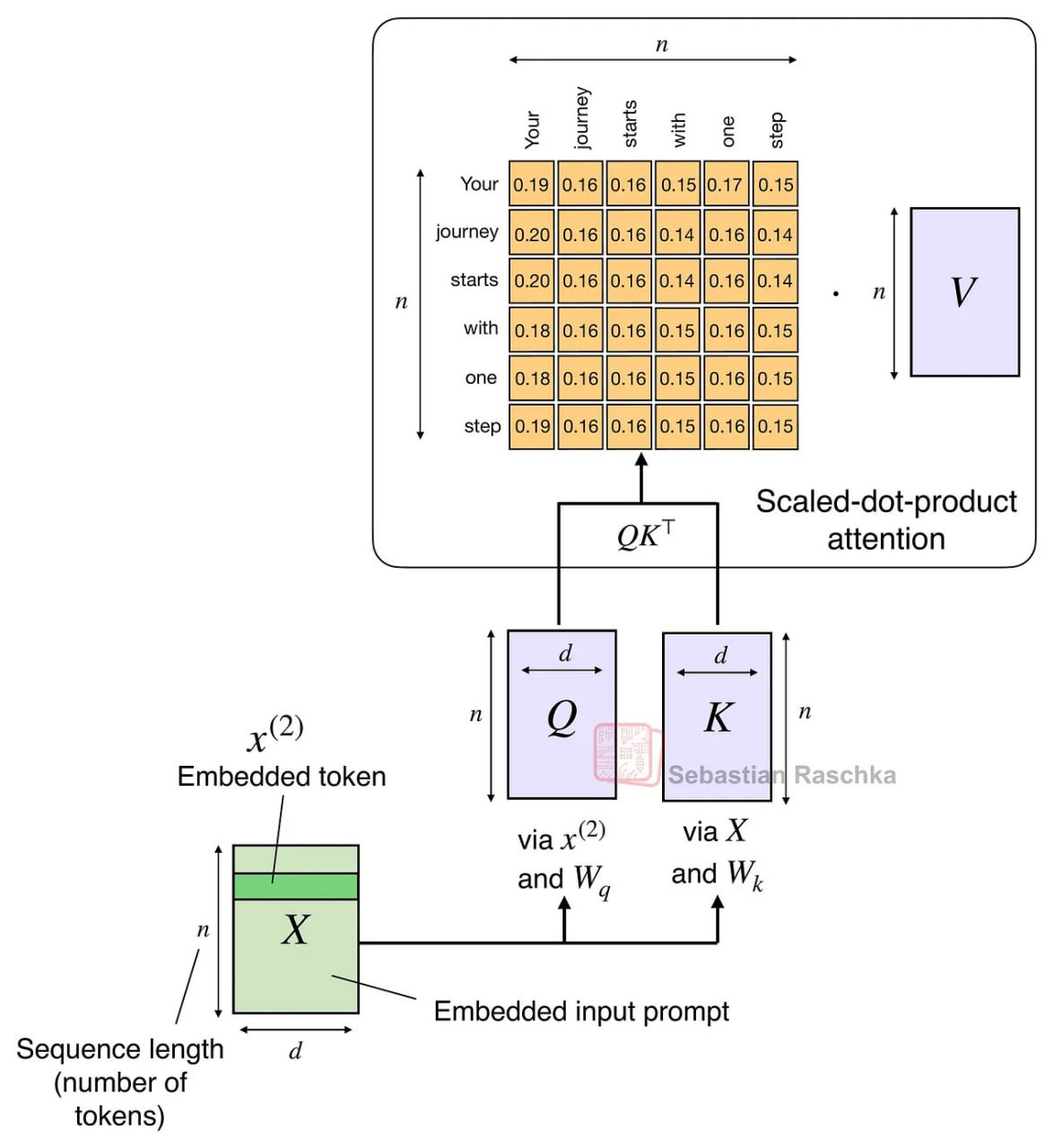

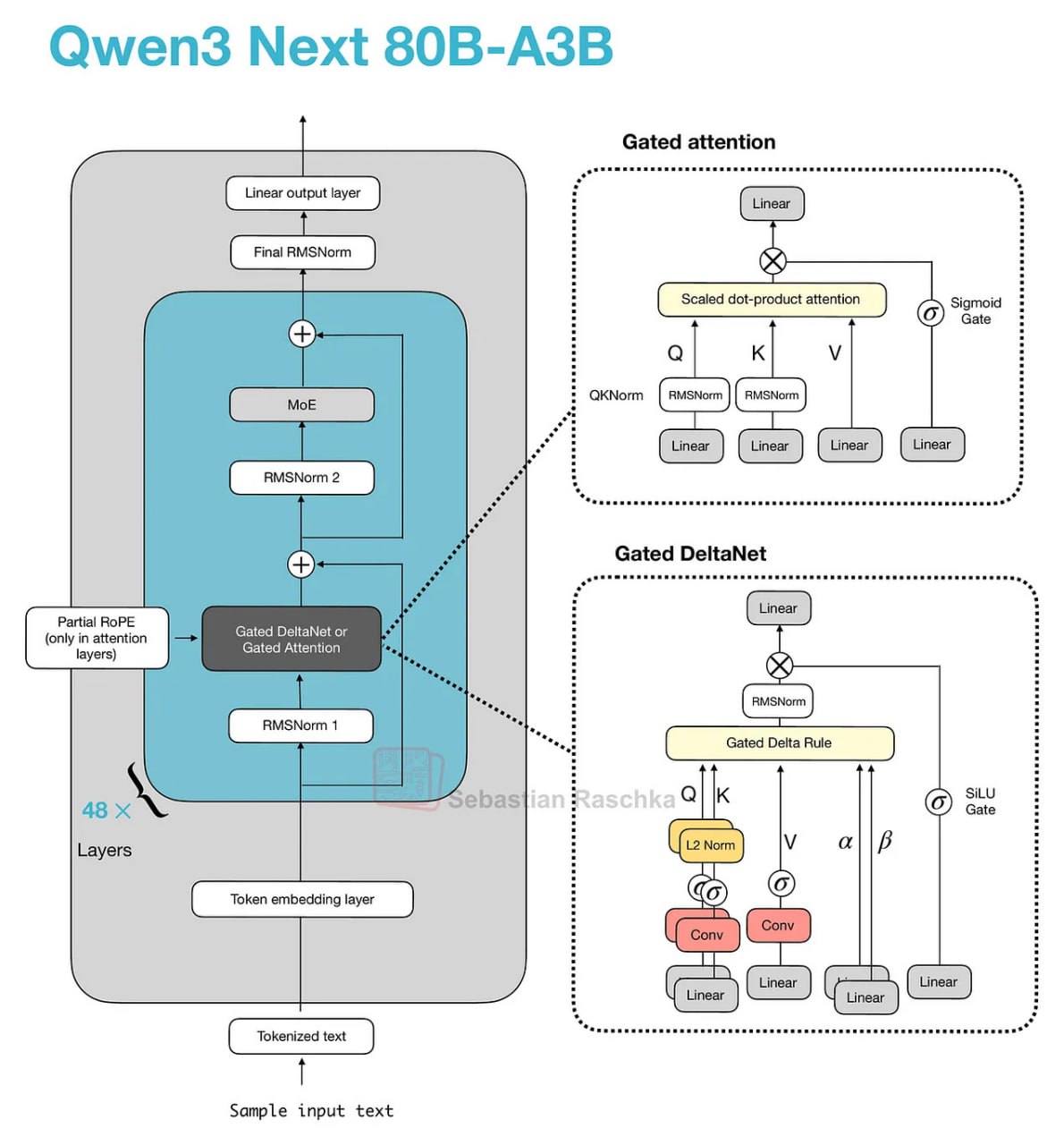

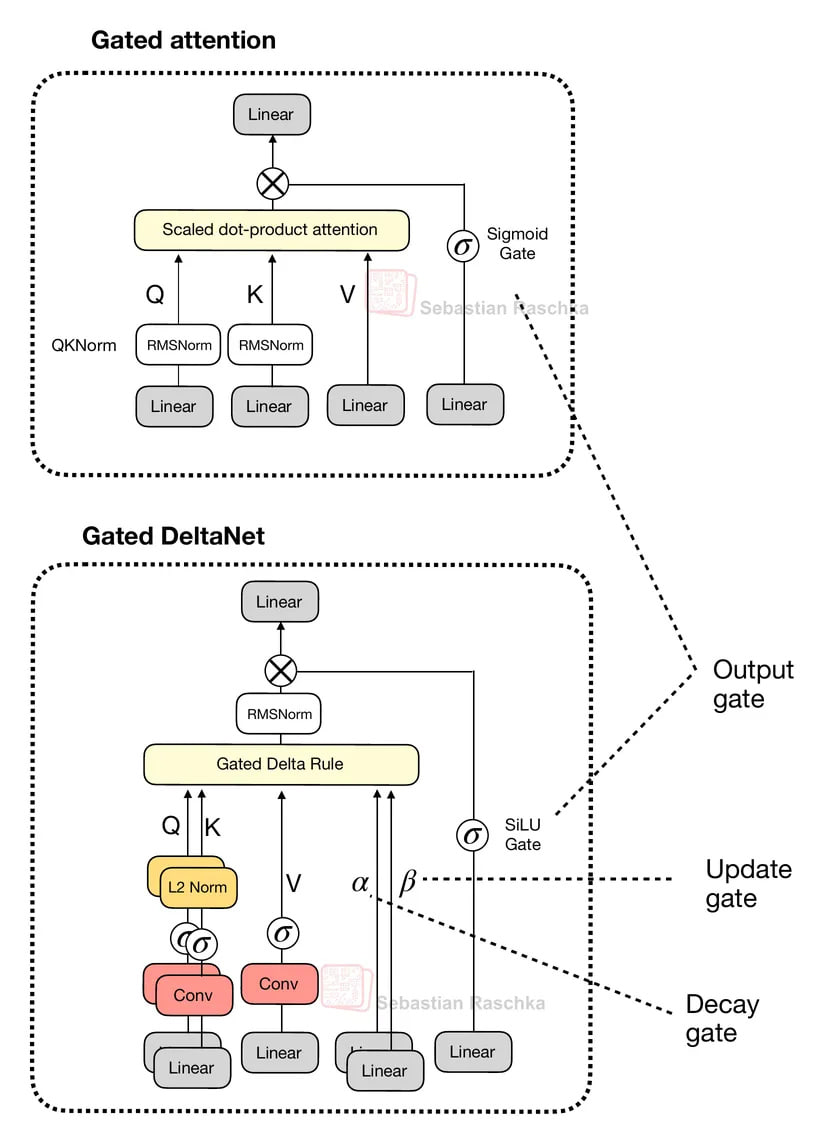

线性注意力混合架构:优化长序列处理效率

线性注意力混合架构代表了当前大语言模型优化的重要趋势。这类模型的核心目标在于显著提升计算效率,特别是在处理长文本序列时的性能表现。传统 Transformer 架构在处理长序列时面临二次计算复杂度的挑战,而线性注意力机制通过巧妙的数学近似实现了线性复杂度,使得模型能够更高效地处理超长文档和复杂对话场景。具体案例包括 Kimi Linear 与 Qwen3-Next 等模型,它们都采用了混合注意力策略,在保持模型性能的同时,能够更精细地控制内存使用和计算资源分配。这种架构的创新之处在于其能够在不同层次上动态调整注意力机制的计算强度,为实际部署提供了更大的灵活性。

文本扩散模型:借鉴图像生成的文本生成新范式

文本扩散模型代表了生成式 AI 的另一个重要发展方向,其核心思想借鉴了图像生成领域已经取得显著成功的去噪扩散概率模型。这些模型通过模拟物理扩散过程,采用逐步去噪的方式生成文本内容,这种方法与传统自回归生成方式形成了鲜明对比。在技术实现上,文本扩散模型首先从纯噪声开始,然后通过多个步骤逐渐去除噪声,最终形成连贯的文本输出。这种生成方式不仅能够实现更高效的并行计算,还能在生成质量上展现出独特优势,特别是在保持文本一致性和逻辑连贯性方面表现突出。随着研究的深入,文本扩散模型有望在创意写作、代码生成等场景中发挥重要作用。

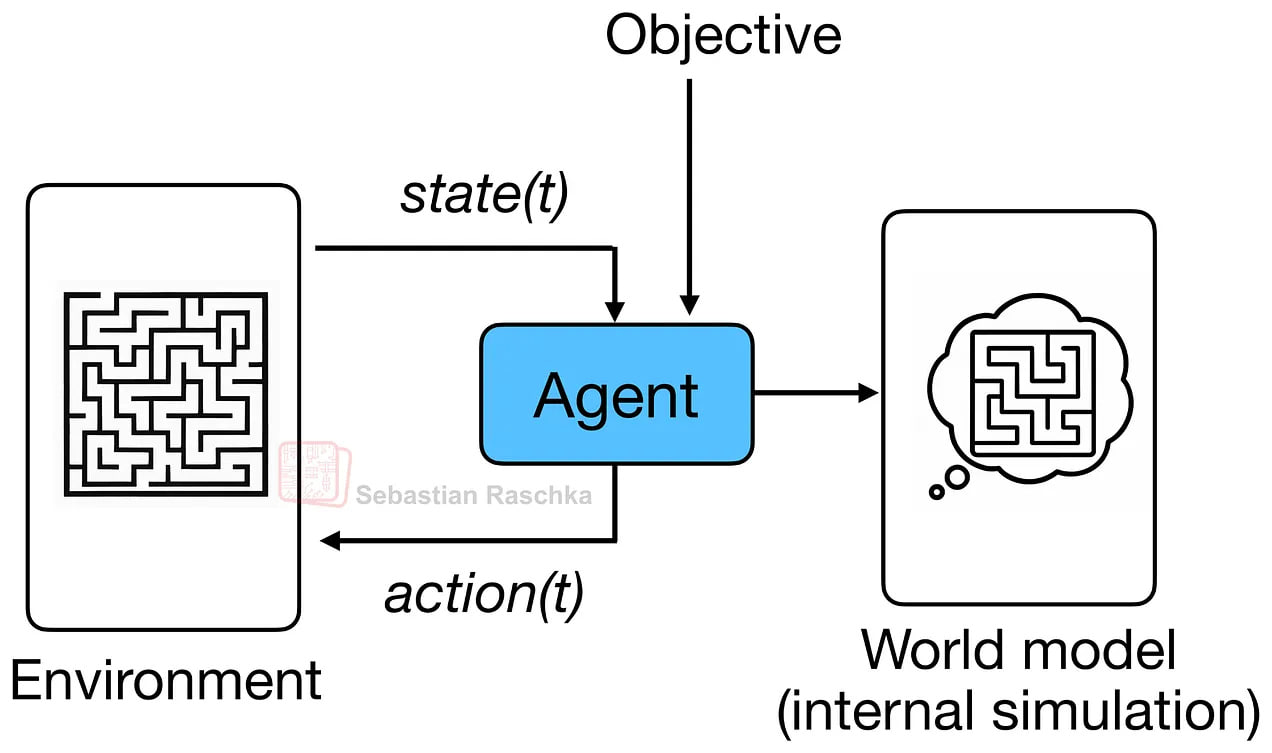

代码世界模型:结合 LLM 与世界模型的创新尝试

代码世界模型是一个极具前瞻性的研究方向,它巧妙地将大语言模型与世界模型的核心思想相结合,尝试通过更深层次的结构化理解来改进代码生成任务。这种模型不仅关注代码的语法正确性,更重视代码在真实执行环境中的语义合理性和功能完整性。虽然目前这类模型大多还处于概念验证和早期研究阶段,但它们为人工智能的发展指明了一条全新的路径。通过建立代码与其执行效果之间的内在联系,代码世界模型有望解决传统代码生成工具在复杂系统理解和上下文把握方面的局限性,为软件开发自动化带来革命性突破。

小型递归变换器:专精特定任务的高效解决方案

小型递归变换器代表了模型专业化发展的重要趋势。这种架构专门针对特定类型的任务进行优化,特别是在逻辑推理、谜题解决和复杂问题分析等场景中展现出独特优势。与传统的大型通用模型相比,小型递归变换器具有参数量少、计算效率高、部署成本低等特点,能够在不牺牲性能的前提下实现更快的推理速度。这种轻量级设计使得它们非常适合作为现有工具调用型大语言模型的补充,在边缘计算、实时应用和资源受限环境中具有广阔的应用前景。通过递归机制的引入,这些模型能够更好地处理序列依赖和长程依赖问题,在特定领域任务中往往能够超越通用大模型的性能表现。

未来展望与总结

这些新兴架构的出现标志着大语言模型技术正在进入一个多元化发展的新阶段。从提升计算效率的线性注意力混合架构,到创新生成范式的文本扩散模型,再到结合深度理解的代码世界模型和专注特定任务的小型递归变换器,每一种方向都为解决当前大语言模型面临的挑战提供了独特的思路。这些技术不仅有望推动自然语言处理领域的进一步发展,还可能为整个人工智能生态系统带来深远影响。随着研究的深入和工程实践的积累,我们有理由相信这些新兴架构将在不久的将来催生出更加高效、智能和实用的 AI 系统。

原文链接:Beyond Standard LLMs