10 大 LLM 提示技巧 提升生成质量

掌握LLM高效提示技巧:从零样本到思维树、代码链,提升生成质量与逻辑推理能力。

在大语言模型(LLM)应用日益广泛的今天,如何有效引导模型生成高质量内容已成为开发者与研究者关注的核心议题。良好的提示设计不仅能显著提升生成文本的准确性与逻辑性,还能拓展模型在复杂任务中的表现边界。本文将系统性地介绍十种高效的提示工程技术,涵盖从基础指令构建到高级推理策略的多个层级,帮助读者真正掌握与 LLM 高效协作的方法。

在初级阶段,建立清晰且具体的指令是有效提示的基础。零样本提示(Zero-Shot Prompting)强调直接给出明确的任务描述,避免模糊或开放式的提问方式。例如,使用“请用三条要点总结这篇文章”远比“你怎么看这篇文章”更容易获得结构化的输出。进一步地,少样本提示(Few-Shot Prompting)通过提供若干示例对(如问答对或任务示范),激发模型的模式匹配能力,使其更好地理解任务目标与响应格式,从而在未知输入上表现更佳。

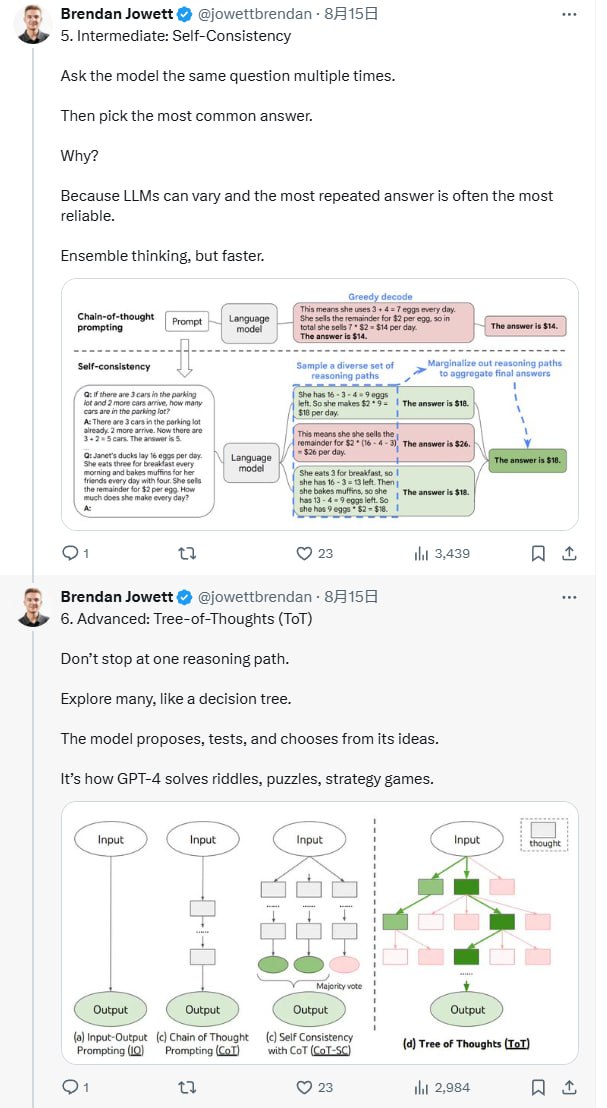

进入中级阶段后,提示设计的重点转向引导模型进行逐步推理与自我验证。思维链(Chain-of-Thought, CoT)方法通过明确要求模型“逐步思考”,促使其展示推理过程,这一方法在数学、逻辑推理等复杂任务中效果显著。自动思维链(Auto-CoT)进一步省略人工编写推理示例的步骤,由模型自主生成推理路径,提高了方法的可扩展性。自洽性(Self-Consistency)技术则通过对同一问题多次采样并汇总高频答案,利用集体共识提升输出的稳定性与可靠性。

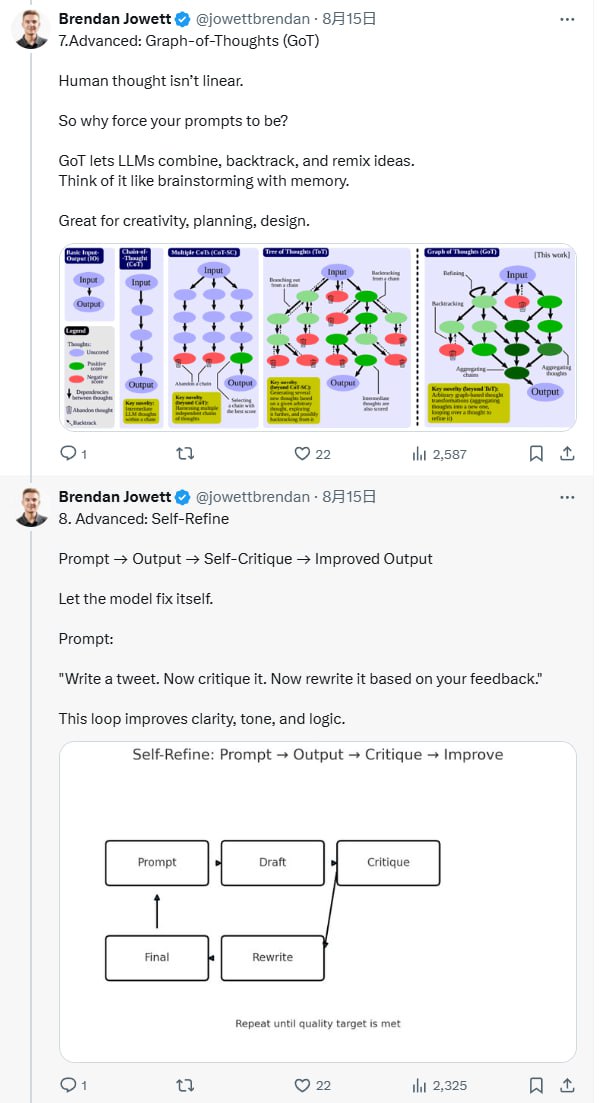

在高级阶段,提示策略侧重于多路径思维探索与迭代优化。思维树(Tree-of-Thoughts, ToT)模仿人类的决策过程,鼓励模型生成多条备选推理路线,并通过评估选择最优解,特别适用于解谜、策略制定等开放型任务。思维图(Graph-of-Thoughts, GoT)则进一步允许思路之间的组合、回溯与融合,更好地支持非线性、创造性的思考过程。自我优化(Self-Refine)方法引导模型进行“生成-批评-改写”的迭代,以提升文本的逻辑连贯性、表达清晰度与语气适宜性。

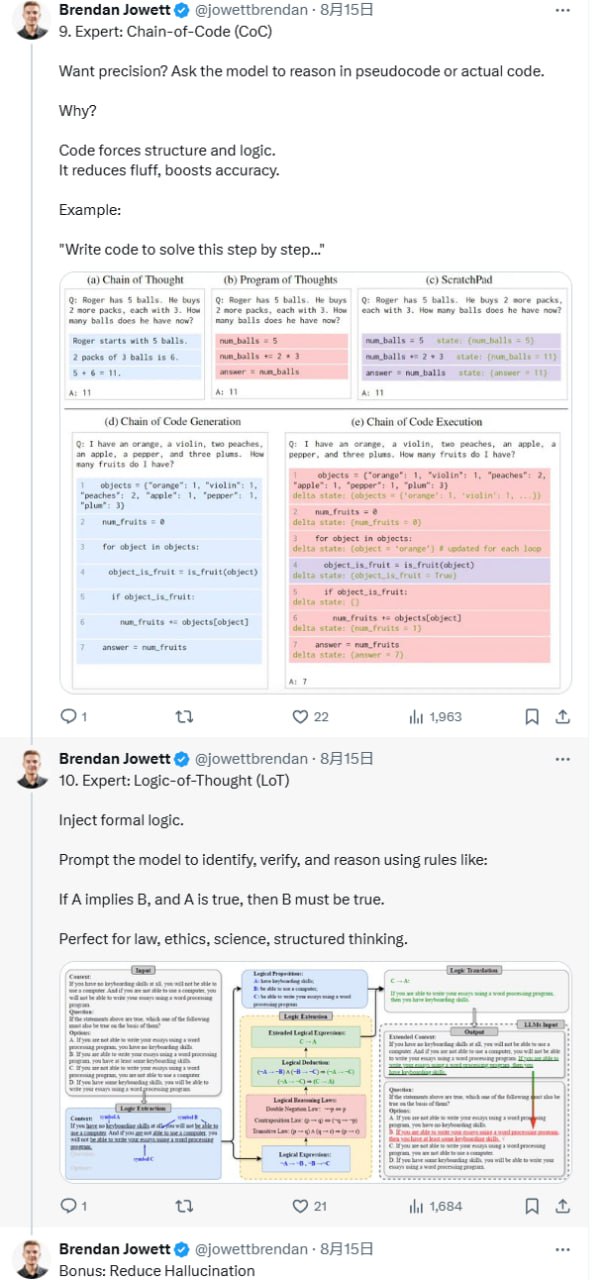

专家级技巧强调程序化与形式化推理的引入。代码链(Chain-of-Code, CoC)借助伪代码或编程逻辑强制模型进行结构化思考,特别适用于算法设计、工程类问题等需要高精度输出的场景。逻辑链(Logic-of-Thought, LoT)则引入形式逻辑规则(如假言推理、拒取式等),增强模型在法律、伦理、科学等领域的严谨性和条理性。

除了上述主流方法,还可结合附加策略以进一步提升生成质量。为减少模型幻觉(Hallucination),可引入检索增强生成(RAG)、ReAct(Reason + Act)或链式验证等技术,通过外部知识检索和过程校验降低错误信息的产生。此外,通过提示语调节生成文本的情绪色彩与风格,例如明确要求“用平静的语气解释”或“像对待十岁孩子一样讲解”,能够显著影响输出的可接受度和沟通效果。

这一系列方法最初由 Brendan Jowett 系统整理并提出,为提示工程的系统化实践提供了重要参考。通过灵活运用上述策略,使用者可在不同任务和场景中显著提升大语言模型的生成质量、逻辑性和实用性。