FullFront:颠覆 MLLM 前端工程评测的终极神器

FullFront是多模态大语言模型前端能力评测平台,覆盖设计、理解与代码生成三大任务,支持主流模型性能评估与优化。

在人工智能技术快速发展的今天,多模态大语言模型(MLLM)在前端工程领域的应用日益广泛。FullFront 作为一个专业的基准测试平台,为评估这些模型在前端设计、理解和代码生成方面的能力提供了系统化的解决方案。

平台核心功能概览

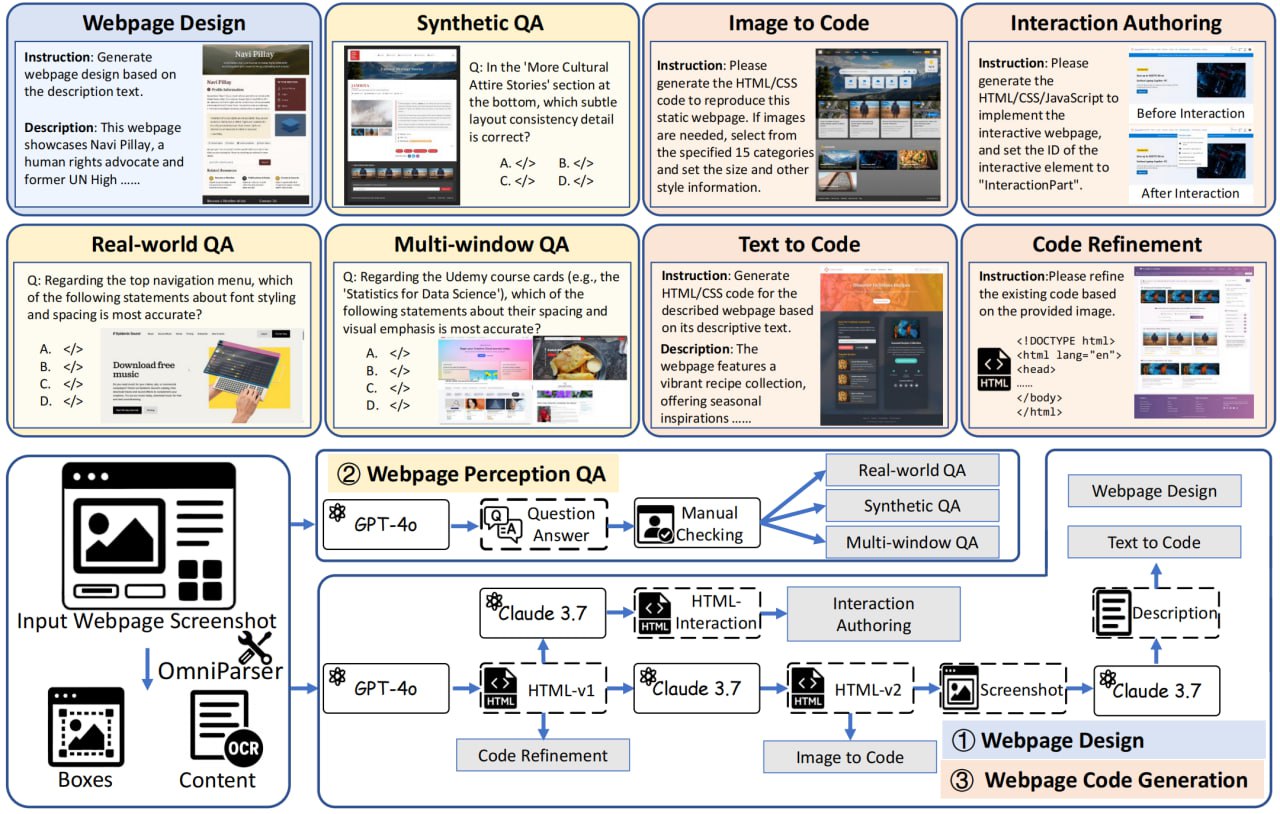

FullFront 平台主要围绕三大核心任务构建其评估体系。首先是 Webpage Design 能力评估,这项测试着重考察模型对视觉元素的组织能力和页面结构的规划水平。通过这项评估,我们可以了解模型在从零开始设计网页时的逻辑性和审美能力。

Webpage Perception QA 是第二个重要评估维度,它专门检测模型对页面视觉布局的理解深度,包括对元素特性及空间关系的认知能力。这项测试能揭示模型"看懂"设计稿的能力,这是实现精准代码转换的基础。

最后是 Webpage Code Generation 评估,这是最具挑战性的环节,考察模型将视觉设计精准转化为功能性代码的水平。FullFront 通过完整的代码生成与评估流水线,从图像相似度和代码质量等多个维度进行综合评分。

技术实现亮点

FullFront 的技术架构支持主流多模态模型的性能评测,包括 Claude、OpenAI 和 Gemini 等知名模型。平台的一个显著特点是能够自动将生成的 HTML 代码渲染成图像,这使得设计稿与生成结果的直观比对成为可能,大大简化了评估流程。

平台提供了丰富的脚本工具,支持批量多模型响应生成与自动化评估。这些工具极大地提高了评估效率,使研究人员能够快速获取多个模型的对比数据。评测结果不仅包含传统的 CLIP 语义相似度,还涵盖了代码结构及内容相似度等专业指标,为深入解析模型表现提供了多维度的数据支持。

应用价值与前景

FullFront 的出现填补了多模态前端 AI 能力系统化评估的空白。通过这个平台,研究人员和开发者可以:

- 客观比较不同模型在前端工程领域的表现

- 识别模型在特定任务上的优势与不足

- 为模型优化提供明确的改进方向

- 跟踪模型迭代过程中的性能变化

随着前端智能化趋势的加速发展,FullFront 这样的专业评估工具将发挥越来越重要的作用。它不仅为当前的技术水平提供了精准测量标准,更为未来的持续优化奠定了坚实基础。

该项目的开源代码托管在 GitHub 平台(FullFront 项目地址),欢迎开发者参与贡献或将其应用于自己的研究项目中。